-

高性能硬件

从 NVIDIA T4 推理 GPU 或其他 AI 加速器,联泰集群推理解决方案可满足您最苛刻的深度学习推理任务。 -

低延迟吞吐量

联泰集群深度学习推理服务器可满足涉及每个查询多个推理的实时用例,例如自动语音识别、语音转文本、自然语言处理等。 -

预安装的框架

联泰集群系统根据要求预装了TensorFlow,PyTorch,Keras,Caffe,RAPIDS,Docker,蟒蛇,MXnet等。

建议的联泰集群深度学习推理数据中心系统

通过联泰集群推理服务器将 AI 带到边缘 – 英伟达 EGX

与客户实时沟通,当数据从数十亿个传感器(从工厂车间到商店货柜过道)流出,进行快速适应;即时诊断疾病并提供挽救生命的患者护理。借助当今强大的 AI 和 NVIDIA EGX 平台,智能零售、医疗保健、制造、运输和城市,所有这些都是可能的,该平台将加速 AI 计算的强大功能带到了边缘。

-

高性能和可扩展性

NVIDIA EGX 具有高度可扩展性,从单节点 GPU 系统开始,一直扩展到整个机架的 NVIDIA T4 服务器,能够提供超过 10000 个 TOPS,为数百名用户提供实时语音识别和其他复杂的 AI 体验。 -

混合云和多云物联网

英伟达 EGX 在架构上与主要云提供商兼容。在云中开发的 AI 应用程序可以在 NVIDIA EGX 上运行,反之亦然。NVIDIA 边缘堆栈连接到主要的云 IoT 服务,客户可以远程管理其服务。 -

企业级且安全

英伟达边缘堆栈已在 RedHat 开放转移(领先的企业级 Kubernetes 容器编排平台)上进行了优化。Mellanox 智能网卡可以卸载和加速软件定义的网络,以实现更高级别的隔离和安全性,而不会影响 CPU 性能。

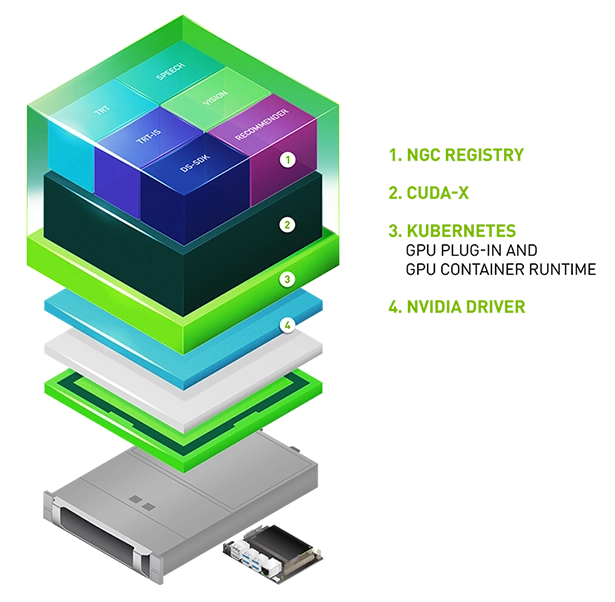

面向边缘的企业级软件堆栈

英伟达边缘堆栈是一个优化的软件堆栈,包括英伟达驱动程序、CUDA® Kubernetes 插件、CUDA 容器环境、CUDA-X 库以及容器化 AI 框架和应用程序,包括英伟达TensorRT™、TensorRT 推理服务器和 DeepStream。

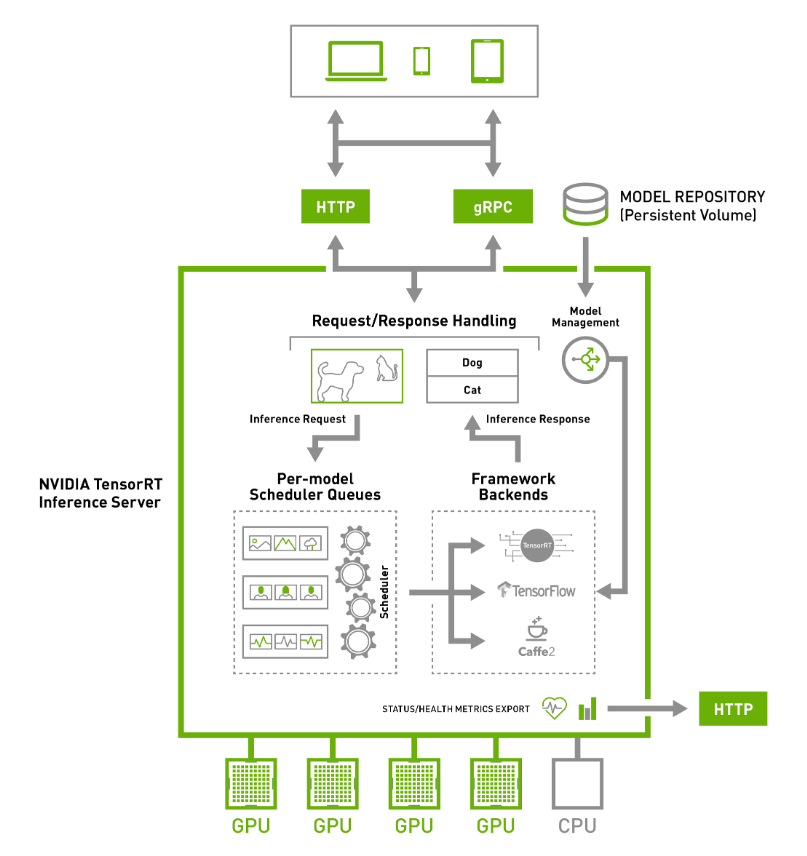

英伟达TensorRT 超大规模推理平台

NVIDIA TensorRT™ 推理平台旨在让世界各地的每个开发人员和数据科学家都能访问深度学习。利用新的图灵架构,Tesla T4 加速了图像、语音、翻译和推荐系统的所有类型的神经网络。Tesla T4 支持各种精度,并加速所有主要的深度学习框架,包括 TensorFlow、PyTorch、MXNet、Chainer和 Caffe2。

推理解决方案的使用场景

|

|

|

|

|||

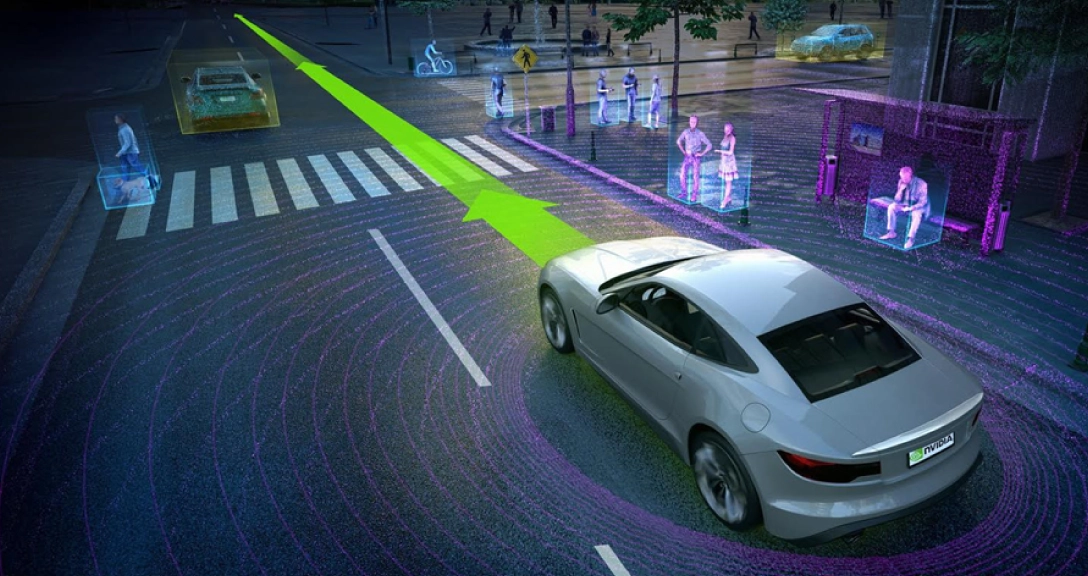

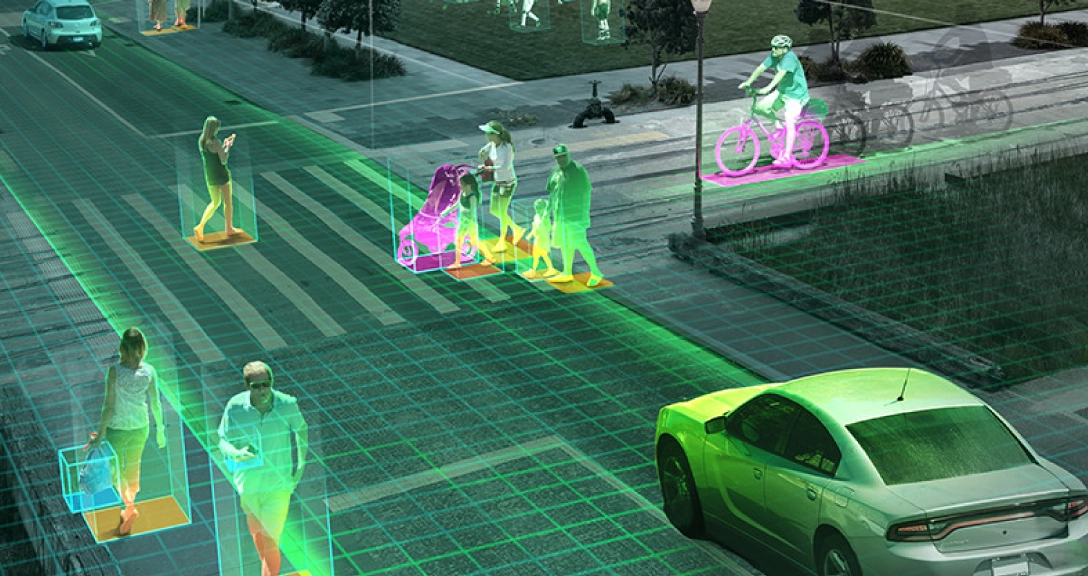

| 数据中心 | 自动驾驶 | 智能视频分析 | 嵌入式设备 |