博客

人工智能、机器学习和数据存储的四个误区

作者:Curtis Anderson 是 Panasas 软件架构师和 MLCommons 存储工作组联合主席

人工智能需要存储……但它需要正确的存储

看 Netflix、谷歌搜索、叫滴滴、用“小爱同学”关灯、解锁手机,甚至选择正确的妆容——这些只是日常我们如何与人工智能和机器学习 (AI/ML) 交互的几个例子。

AI/ML 的核心是模式识别。实时识别模式的能力为改进业务流程、企业收入和人们的生活提供了无数可能性。IDC预计,2026年全球人工智能市场(包括软件、硬件和服务)将达到9000亿美元大关,2022-2026年复合年增长率(CAGR)为18.6%。

随着越来越多的组织采用 AI/ML,他们的 IT 团队将更加关注实用性,即如何经济高效地构建和管理能够支持这些强大功能和规模以实现未来增长的基础架构。如果说该过程的一个组成部分仍然被特别低估和误解,那就是支持这些新兴应用程序所需的数据存储基础设施。

以下是四个需要破除的常见 AI/ML 存储误区。

1 - AI/ML 都是关于 GPU 的

在具有极高计算能力的现代图形处理单元 (GPU)出现之前,当今使用的 AI/ML 应用程序和神经网络只不过是一个迷人的概念。加速器芯片无疑对 AI/ML 应用至关重要,但如果没有足够的存储和网络,它同样毫无价值。

存储和网络是真正的左膀右臂。它们确保在完成当前数据集之前,下一组数据可用于加速器。因此,存储和网络基础设施的选择必须像 GPU 一样仔细考虑。事实上,必须平衡每个元素才能获得最佳结果:过多的存储性能或容量将被浪费,而太少则会导致昂贵的计算资源闲置。

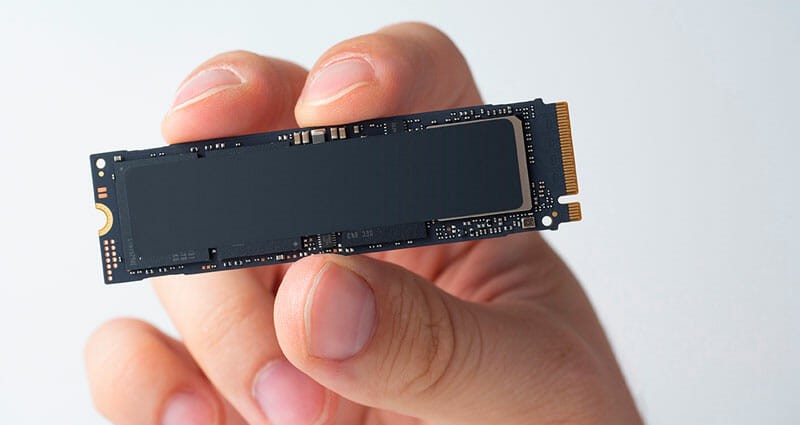

2 - AI/ML 需要高 IOPs 全闪存存储

为了“喂养野兽”,加速器要求数据随时随地可用。这意味着 AI/ML 存储不仅仅是纯粹的速度。具有令人印象深刻的高 IOP 的昂贵的全闪存存储系统很可能会浪费预算。

加速器具有不同级别的性能,不同的 AL/ML 应用程序也是如此。例如,在对象识别应用程序中,每张图像的计算时间足够长,以至于混合(硬盘驱动器和固态磁盘)系统可以像全 NVMe 解决方案一样工作,而且价格要低得多。IT 团队需要平衡他们的计算加速器、AI/ML 工作负载和他们的存储选项,以找到最佳解决方案。MLPerf等独立基准测试可以在这方面提供帮助。

3 - 存储分层将降低 AI/ML 成本

分层存储是最大化存储资源和最小化成本的常见策略。关键任务和经常访问的“热”数据放置在昂贵且快速的存储介质(即 SSD)上,而很少访问或更新的“冷”归档数据保存在最便宜的存储设备(即磁带)上。尽管一种广泛采用的方法可以经济高效地管理存储需求,但该模型不能应用于 AI/ML 应用程序。那是因为在 AI/ML 中没有冷数据这样的东西。

AI/ML 将推动整个企业的大规模转型。底层存储基础设施的选择将影响 AI/ML 应用程序的价值

所有 AI/ML 训练数据都用于每次训练运行,因此将一些训练数据分层到不同的存储层只会减慢过程。相反,AI/ML 存储解决方案必须将所有数据视为“热”数据,并确保所有数据始终可用。

同时,AI/ML 工作负载的准确性随着可用训练数据量的增加而增加。这意味着存储基础设施必须能够随着训练数据量的增加而无中断地扩展。与存储分层相比,横向扩展线性增长是这些环境的关键存储要求。

4 - AI/ML 可以有效利用专用的一次性存储系统

AI/ML 在应用于组织的核心数据时最有价值。例如,银行正在采用这些技术进行欺诈检测,药品制造商可以更好地分析来自实验或制造的数据,以加快药品开发。就亚马逊的杂货店或人工智能化妆公司而言,人工智能技术是其技术和业务基础设施的核心。对于许多企业而言,AI/ML 不再是可以由专用的一次性存储系统提供服务的实验性项目;相反,它们已成为业务不可或缺的一部分。因此,这些应用程序必须整合到组织的核心 IT 基础架构和存储解决方案中。

做出明智的选择...

AI/ML 创新将推动整个企业的大规模转型,并影响组织的几乎每个方面。根据 Gartner 技术成熟度曲线,许多技术有望在未来两到五年内成为主流,例如边缘人工智能、决策智能和深度学习。随着组织开始各自的旅程来应用这种强大的新技术,底层存储基础设施的选择将对组织最大限度地发挥 AI/ML 应用潜力的能力产生重大影响。

相关贴子

-

存储

存储联泰集群基于龙芯3C5000处理器的国产高性能存储服务器——SL423

2022.07.14 22分钟阅读 -

存储

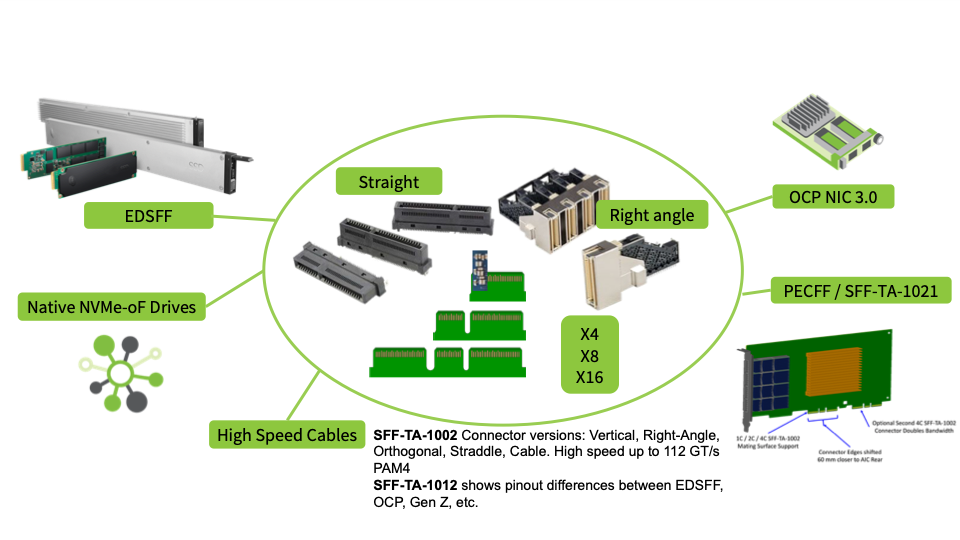

存储固态硬盘外形尺寸

2023.02.11 170分钟阅读 -

存储

存储双列直插式内存模块之间的差异:RDIMM 与 LRDIMM

2023.12.22 11分钟阅读