博客

【速看】TensorFlow 2.17 发行说明

TensorFlow 2.17 已经发布!此版本(和 2.16)的亮点包括 CUDA 更新、即将推出的 Numpy 2.0 等。有关完整的发布说明,请访问 TensorFlow 的 GitHub。

-

CUDA 更新

-

Numpy 2.0

-

放弃 TensorRT 支持

-

修复错误和其他 TensorFlow 2.17 更改

-

对于动态范围量化用例(float32 输入/输出和 int8 权重),FullyConnected 层的量化从每个张量切换到每个通道尺度。这一变化在转换器和推理引擎中全局启用了新的量化模式。可以通过实验性功能开关禁用新行为converter._experimental_disable_per_channel_quantization_for_dense_layers = True. -

C API:实验性的 TfLiteRegistrationExternal 类型已被重命名为 TfLiteOperator,相应的 API 函数也是如此。

-

Python TF Lite 绑定的编译器现在有一个选项 experimental_default_delegate_latest_features,用于启用所有默认委托功能。

-

Flatbuffer 版本更新:GetTemporaryPointer() 错误已修复。

-

将 wait 添加到 tf.data.Dataset.load。如果为 True,对于使用 distributed_save 编写的快照,它会在写入快照时读取快照。对于使用常规 save 写入的快照,并会等待快照直到完成。为了向后兼容,默认值为 False。建议 distributed_save 的用户将其设置为 True。

-

为少数核心用户添加 compute_sparse_core_stats,用这个 API 对数据进行配置,以获得 max_ids 和 max_unique_ids。配置少数核心嵌入中层 API 需要这些数字。

-

删除 preprocess_features 方法,因为不再需要它。

-

Keras 3.0 主要更新:

-

Keras 现在可以在 JAX、PyTorch、TensorFlow 甚至 NumPy 之上运行(请注意,NumPy 后端仅用于推理)。

-

新的低级 keras.ops API,用于构建跨框架组件。

-

基于 JAX 的新型大规模模型分发 keras.distribution。

-

用于层、模型、优化器和度量的新的无状态 API。

-

Keras 3.5 最新更新

-

添加与 Hugging Face Hub 的集成。现在,您可以直接从 keras 将模型保存到 Hugging Face Hub。使用 keras.saving.load_model() 直接从 Hugging Face Hub 加载 keras.Model.save() 和加载 .keras 模型。

-

确保与 NumPy 2.0 兼容。

-

添加 keras.optimizers.Lamb 优化器。

-

改进 keras.distribution API 对超大模型的支持。

-

添加 keras.ops.associative_scan 操作。

-

添加 keras.ops.searchsorted 操作。

-

添加 keras.utils.PyDataset.on_epoch_begin() 方法。

-

将 data_format 参数添加到 keras.layers.ZeroPadding1D 图层。

-

Bug 修复和性能改进。

相关贴子

-

技术分享

技术分享AlphaFold 更新显著提高了对接、核酸和 PTMS 的准确性

2024.04.12 14分钟阅读 -

技术分享

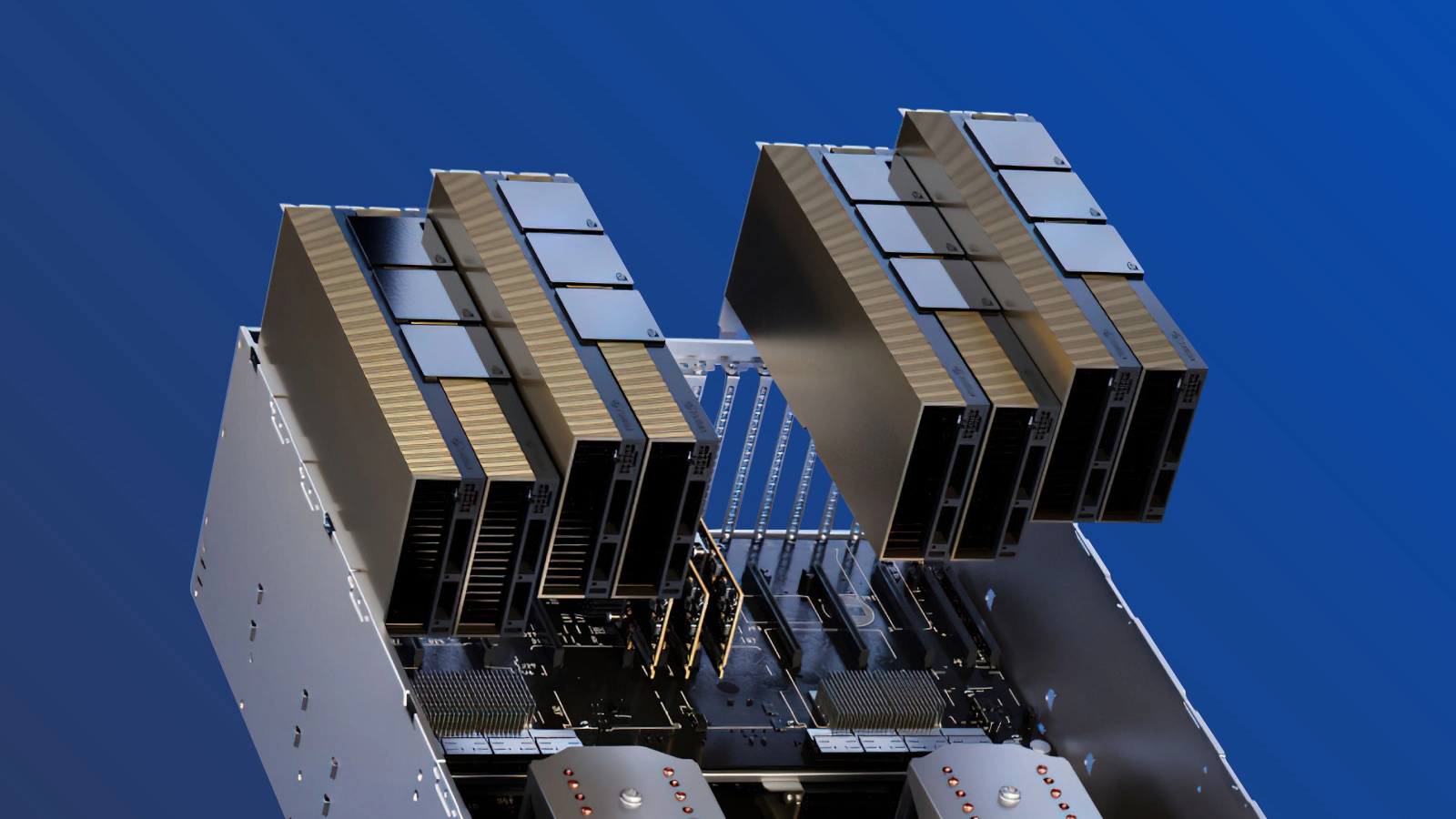

技术分享什么是 OCP 3.0 NIC?

2025.07.25 30分钟阅读 -

技术分享

技术分享我们什么时候该对 LLM 进行微调和使用 RAG ?

2024.10.18 38分钟阅读