博客

随时随地访问开源 LLMs-Ollama 的移动 LLMs

随着人工智能的不断进步,对开发人员、研究人员和技术爱好者来说,利用这项技术的强大工具的可访问性变得越来越重要。

ChatGPT、Gemini 等大型语言模型(LLMs)以及 Llama 和 Mistral 等开源替代品彻底改变了我们与机器学习的互动。这些模型是从简单的聊天机器人到复杂决策系统的广泛应用的支柱。然而,管理这些强大的工具通常需要相当多的专业知识,这对许多用户来说是一个重大挑战。

我们将指导您如何远程访问这些开源模型,重点介绍如何使用 Ollama 管理您的模型,Ollama Web UI 以增强交互体验,以及如何使用ngrok远程访问我们为 Ollama 模型创建的本地环境。

-

Ollama 是什么?

Ollama 是一个用户友好的平台,简化了 LLM 的管理和操作,即使是那些只有适度技术背景的人也可以使用尖端的人工智能。Ollama 旨在简化 LLM 的管理和部署,它不仅是一种工具,也是一座通往更广泛地了解人工智能潜力的桥梁。无论您是使用先进的专有模型还是探索可访问的开源模型的可能性,Ollama 都提供了一个用户友好的平台来利用这些变革性技术的能力。

-

Ngrok 是什么?

Ngrok 是一个功能强大的反向代理工具,有助于安全可靠地远程访问本地服务器设置。我们将使用 ngrok 创建一条通往您的 Ollama 环境的隧道,让您可以从任何位置管理您的 LLM 并与之交互。

Ngrok对于那些希望随时随地访问模型而无需随身携带计算的开发人员来说至关重要。无论物理位置如何,它都能为您的AI工具提供稳定安全的连接。

我们将主要关注两种模型:Llama 3:70b,具有强大的计算资源;Mistral 7B,非常适合初学者或资源有限的人。无论您是经验丰富的开发人员还是好奇的新手,本指南都将指导您使用 Ollama 和 ngrok 进行远程访问,完成LLM的设置、运行和优化。

以下是链接:

https://ollama.com/library/llama3

https://ollama.com/library/mixtral

https://ollama.com/library/mistral

一、安装

开始使用 Ollama 很简单,特别是如果你使用的是 Linux 环境。下面,我们详细介绍了 Linux 用户的步骤,并为其他平台上的用户提供了资源。

在 Linux 上安装 Ollama:

1.下载和安装:首先打开终端并输入以下命令。此脚本自动安装 GitHub,确保安装过程顺利:

curl -fsSL https://ollama.com/install.sh | sh

此命令直接从 Ollama 的网站检索安装脚本并运行它,在您的 Linux 系统上设置 Ollama,为您的激动人心的旅程做好准备。

2.启动 Web UI:安装 Ollama 后,您可以使用 Docker 启动基于 Web 的用户界面,这有助于在隔离环境中运行 Ollama:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

此命令在 Docker 容器中运行 Ollama Web UI,将容器的端口8080映射到主机上的端口3000。--restart always 选项可确保 Docker 容器在崩溃或重新启动系统时自动重启。在这里查看 Ollama 的 Github for WebUI。

二、其他平台的安装:

对于那些使用 macOS、Windows 的人,或者即使在 Linux 上也更喜欢基于 Docker 的安装的人,Ollama 支持其他几种安装方法,包括 Ollama 下载网站上的安装 exe 文件,或者参考 Ollama GitHub 官方存储库,以获取针对每个平台量身定制的详细说明。此存储库包括全面的指南和故障排除提示,可帮助您在各种环境中设置 Ollama。

三、了解 Web UI:

Ollama Web UI 是一个关键功能,它提供了一个简单直观的界面,允许您与大型语言模型(LLM)无缝交互。Web UI 旨在提高用户友好性,使从初学者到高级从业者的所有技术水平的用户都可以访问管理 LLM。

四、访问 Web UI:

要开始探索 Ollama 的功能,请打开您的网络浏览器并导航到:http://localhost:3000

此地址将引导您访问本地托管在您的计算机上的 Ollama Web UI 的登录页面。

五、设置帐户:

到达登录页面后,您需要创建一个帐户。由于此环境是本地的,因此所有用户数据都安全地存储在 Docker 容器中。请随意使用任何首选用户名、电子邮件和密码,因为这些信息不需要绑定到任何外部帐户:

-

点击“注册”按钮进行注册。

-

输入您选择的姓名、电子邮件和密码。

-

提交您的详细信息以创建帐户。

六、与界面交互:

登录后,将显示主界面,您可以在其中选择一个 LLM 进行交互。用户友好的仪表板允许您轻松开始对话并探索每个模型的不同功能。

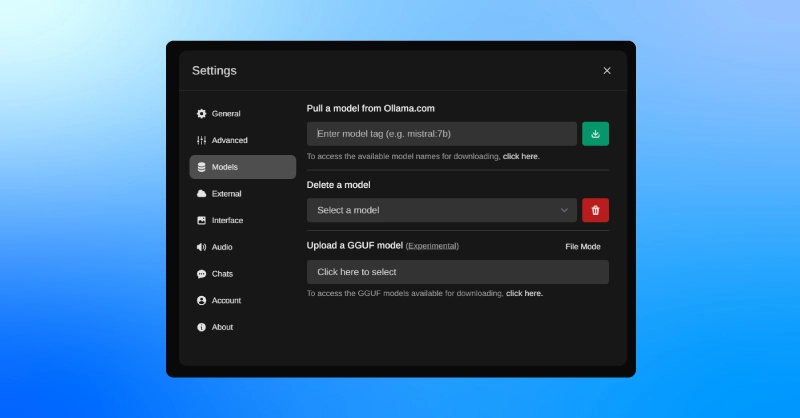

七、下载其他型号:

如果您想扩展型号选择:

-

导航到“设置”页面,可从主菜单访问。

-

单击设置中的“模型”选项卡。

-

在这里,您可以通过输入上提供的型号标签下载其他型号 http://Ollama.com 。

-

点击“下载”以启动该流程。下载完成后,新模型将出现在主屏幕上供选择。

Ollama Web UI 旨在为使用和学习 LLM 提供一个强大而简单的环境,增强您的体验,使有效管理这些复杂的模型变得更加容易。

八、选择正确的 LLM

在选择合适的大型语言模型时,决策在很大程度上取决于您的特定需求和资源。在选择 Ollama 的图书馆时,请记住以下几点:

-

模型大小和资源要求:像 Llama 3 这样的大型模型需要大量的计算能力,但提供了更多的功能。相比之下,像 llama3:8b 这样的较小型号更易于管理,但可能不那么强大。

-

任务特异性:考虑你需要模型做什么。对于详细、复杂的任务,可能需要一个更大的模型,而对于一般用途,一个更小的模型就足够了。

让我们考虑一个场景,你想与你的 LLM 就一个一般主题进行互动。这里有一个简单的方法:

-

配置您的模型:

-

选择并加载 LLM:在 Ollama Web UI 中,从可用 LLM 列表中选择 llama3:8b 型号。此模型在性能和资源使用之间提供了良好的平衡,使其成为一般查询的理想选择。

-

加载模型:单击该选项加载所选模型,为交互做准备。

-

设置交互:

-

访问聊天界面:导航到 Ollama Web UI 中的聊天界面。在这里,您将键入问题并获得答案。

-

精心设计你的提示:要发起对话,请在聊天框中键入一个简单的提示。

-

例如:

-

营养顾问:“我想吃得更健康,但很难制定饮食计划。你能做我的营养顾问,建议我每周的饮食计划吗?”

-

家庭作业导师:“我的物理作业需要帮助。你能做我的导师,解释量子力学的概念吗?”

-

编程助理:“我遇到了一个编码问题,需要一些帮助来调试我的 Python 脚本。你能做我的编程助理吗?”

-

测试和改进:

-

与 LLM 互动:提交您的提示并查看 LLM 的回复。初始交互可以帮助您衡量模型理解和输出的有效性。

-

优化你的提示:根据回答,你可以选择优化你的问题或提出后续问题,以更深入地探讨这个话题。

这个用例演示了使用 Ollama 与 LLM 进行交互的一种基本而有效的方法。无论您是简单地探索人工智能功能还是寻求特定信息,Ollama 界面的简单性都可以实现快速调整和交互式学习。请随时尝试不同的问题和设置,以发现您的 LLM 的全部潜力。

-

使用 ngrok 进行远程访问

提供对 LLM 设置的远程访问可以大大提高其可用性,特别是如果你想从不同的位置或设备管理或与你的模型交互。Ngrok 是实现这一目的的宝贵工具,因为它为您的本地服务器创建了一个安全的隧道。

以下是关于如何设置它的详细指南:

1.安装 ngrok:

-

注册和登录:访问 ngrok 网站并注册一个帐户。注册后,登录以访问您的仪表板。

-

导航到设置:在 ngrok 仪表板中,在“设置和安装”下找到“入门”部分仪表板的这一部分旨在指导新用户完成初始设置过程。

-

选择您的操作系统:选择 Linux 代理,它将显示针对 Linux 环境定制的特定说明。

-

下载和安装:按照提供的详细说明在 Linux 系统上下载和安装 ngrok 客户端。

2.验证 ngrok:

-

检索您的身份验证令牌:安装后,您可以在 ngrok 仪表板上找到您的唯一身份验证令牌。此令牌对于将您的本地 ngrok 客户端链接到您的 ngrok 帐户至关重要。

-

验证您的客户端:打开一个终端并运行以下命令,将您的身份验证令牌添加到 grok:

ngrok config add-authtoken [Your_Auth_Token]

-

用提供的实际令牌替换 [Your_Auth_Token]。此步骤可确保您的会话安全并链接到您的帐户。

3.连接到 Ollama:

-

运行 ngrok:一旦通过身份验证,您就可以启动 ngrok 会话,将 Ollama Web UI 暴露给互联网。确保 Ollama Web UI 在其默认端口(通常为3000)上运行。然后,在您的终端中,执行:

ngrok http http://localhost:3000

-

远程访问 Ollama:ngrok 将提供一个 URL,您可以使用该 URL 远程访问您的 Ollama 实例。此 URL 充当到本地服务器的安全网关,允许您在任何可以访问互联网的地方管理 LLM 并与之交互。

按照这些步骤,您可以设置 ngrok,以提供对 Ollama Web UI 的安全便捷的远程访问,大大提高了 LLM 管理的灵活性和可访问性。

-

安全和隐私考虑

虽然 ngrok 是一个强大的远程访问工具,但它也引入了一些您必须解决的安全问题:

-

保护您的连接:始终使用 HTTPS 通过 ngrok 访问您的 Ollama web UI。这可确保您的数据在传输过程中得到加密。

-

监控访问:密切关注 ngrok 提供的访问日志。如果您发现任何不熟悉或可疑的活动,请进行调查并采取适当行动。

-

限制暴露:仅在需要时保持 ngrok 连接处于活动状态。长时间暴露会增加未经授权访问的风险。

通过遵守这些最佳实践,您可以将风险降至最低,并确保您对 Ollama 和 ngrok 的使用保持安全和私密。

当您可以直接从移动设备与 LLM 设置进行交互时,将带来极大的便利。按照前面概述的 ngrok 设置,在移动设备上访问 Ollama 实例很简单。操作方法如下:

-

通过 ngrok URL 访问:一旦 ngrok 运行并公开您的 Ollama 实例,它将为您提供一个 URL。只需在移动设备上的浏览器中输入此 URL 即可。

-

移动界面:Ollama web UI 的设计是响应式的,这意味着它应该调整以适应您的移动屏幕。这种可访问性确保您可以在手机上像在计算机上一样轻松地管理 LLM 并与之交互。

这种能力不仅增加了您在哪里以及如何使用 LLM 的灵活性,还确保您可以更方便地展示或与他人分享您的项目,无论是在会议、教室还是非正式讨论中。

恭喜您通过 Ollama 开始您的大型语言模型之旅!我们鼓励您探索 Ollama、Mistral 和 Lama 等开源项目不断发展的能力。这些平台不仅突破了生成式人工智能的极限,还使尖端技术更容易获得。随着最新技术的不断进步,它为更多的人接触这些强大的工具并从中受益打开了大门。

在配备 GPU 的本地 PC 上运行这些模型的能力不仅具有强大的功能,而且具有变革性。它使您能够完全控制工具,从而更深入地了解和定制技术。随着人工智能的不断进步,模型变得越来越小,效率越来越高,预示着未来任何人都可以在家里使用高级人工智能工具。

在联泰集群,我们提供必要的硬件,使这一未来在今天成为现实。配置您自己的深度学习工作站、服务器,甚至一个完整的机架,以推动您的人工智能开发。有了我们强大的、随时可部署的系统,您就拥有了开始培训、开发和部署自己的 LLM 所需的一切。使用联泰集群深入人工智能世界,我们提供计算和存储,以释放您的创造力。

相关贴子

-

人工智能与大模型

人工智能与大模型会思考的 AI:自主推理人工智能

2025.03.14 29分钟阅读 -

人工智能与大模型

人工智能与大模型GROMACS 2025.3 补丁版本发布说明

2025.11.28 24分钟阅读 -

人工智能与大模型

人工智能与大模型LM Studio-如何在自己的机器上运行生成式人工智能

2024.09.27 32分钟阅读