博客

使用 Continue VS Code Extensions 在本地运行 LLM

人工智能(AI)已成为开发人员不可或缺的工具。GPT-4o 等大型语言模型(LLM)通过辅助从自动完成代码到生成整个函数的一切,彻底改变了编码。虽然基于云的人工智能服务已经成为常态,但越来越多的人转向在本地运行LLM。此举为开发人员提供了更多的控制、更快的响应和增强的安全性。随着 Deepseek R1 Distill Qwen 32B 等先进开源模型的出现,现在是考虑升级硬件和采用本地 AI 模型的最佳时机。

在本地部署自己的 LLM 对于寻求更快的实时帮助、隐私和安全的开发人员来说是有利的。虽然传统的人工智能聊天机器人服务是可选的,但它们并没有完全集成到工作流程中。开源模型可以弥补工作流和助手之间的脱节,提高生产力和用例。

-

更快的实时协助:在本地运行 LLM 消除了与基于云服务相关的延迟。当模型在您的机器上时,响应是即时的,可以提供更流畅、更高效的编码体验,大大加快了开发周期。

-

隐私和安全优势:使用基于云的人工智能服务通常涉及将您的代码(可能包含敏感信息)发送到第三方服务器。在本地运行 LLM 可确保您的代码保留在您的计算机上,提供额外的安全层,这对于从事专有或机密项目的开发人员至关重要,因为数据泄露可能会产生严重后果。

-

提高灵活性和定制化:本地 LLM 允许您自由定制模型以满足您的特定需求。您可以微调模型,控制更新,并选择要部署的模型。

Deepseek R1 Distill Qwen 32B 简介

Deepseek R1 Distill Qwen 32B 是最新的开源编码模型,它是从行业领先的 Deepseek R2 模型中提炼出来的,该模型在推理和准确性方面击败了其他流行的 AI 模型。Qwen 系列的开发重点是提高编码能力,同时保持数学和一般任务的强大性能。Deepseek R1 蒸馏器 Qwen 32B 包括:

-

多语言支持:支持超过 92 种编码语言

-

经过广泛训练和提炼:拥有超过 320 亿个参数,并从最有效和最复杂的模型之一中提炼出来。

-

开源:根据 Apache 2.0 许可证发布,鼓励广泛采用和定制。

-

IDE 集成:与流行的集成开发环境(IDE)和代码编辑器兼容。

-

强大的安全性:确保数据隐私和完整性,这对当地发展至关重要。

Deepseek R1 Distill Qwen 32B 在代码生成和完成、代码推理以及数学推理和问题解决方面表现出色。开源模型因其协作性质而不断发展,突破了本地 LLM 代理的界限。Deepseek R1 Distill Qwen 有几种型号,包括 14B 和 7B,用于重量更轻的部署,甚至是从 Llama 70B 中提取的 70B 模型,可以带来更多的功能和更强的关注。

我们专注于 Deepseek R1 Distill Qwen 32B,这是一个专业级的选择,非常适合那些拥有高性能GPU的人,可以在不牺牲质量和功能的情况下为模型供电。

LLM 正变得越来越高效,具有更小的模型尺寸,不会影响性能。模型优化方面的创新意味着,像 Deepseek R1 Distill Qwen 32B 这样强大的 LLM 越来越容易被没有顶级硬件的开发人员使用。如果你的硬件不够强大,无法提供快速响应,那么较小的 Deepseek R1 Distill Qwen 14B 和 7B 选项可以作为计算密集度较低的替代品。

-

代码摘要:理解复杂的代码库或不熟悉的代码可能会很耗时。我们的模型由 Deepseek R1 Distill Qwen 32B 提供支持,可以快速总结大块代码,帮助您在不阅读每一行的情况下掌握功能。

-

示例:突出显示一个函数,并要求模型提供摘要,并收到代码功能的简洁解释。

-

代码增强:该模型可以帮助在整个代码中插入调试语句或控制台日志。这种自动化有助于更有效地跟踪数据流和识别错误。

-

示例:请求模型向特定函数添加调试语句。它将在关键点插入适当的日志,使您无需手动插入。

-

单元测试生成:编写单元测试是必不可少的,但往往很乏味。它可以根据您的代码生成单元测试,确保更好的覆盖率和可靠性。

-

示例:为模型提供一个函数,并要求它生成单元测试。您将收到可以直接集成到测试框架中的测试用例。

-

自动补全:由 Deepseek R1 Distill Qwen 32B 支持的自动补全功能超越了简单的代码建议。它理解上下文,可以预测复杂的代码结构,使您的编码过程更快、更高效。

-

示例:当你开始键入一个函数时,模型会预测整个代码块,包括参数和返回语句,使你能够以闪电般的速度编码。

LLM 的潜在应用正在扩大。未来的用例可能包括:

-

文档生成:根据您的代码自动创建文档。

-

项目管理:使用人工智能来估计时间表或建议任务优先级。

-

代码库分析:识别潜在的瓶颈或安全漏洞。

拥抱 LLM 使您先一步栖身于即将到来的进步前沿。

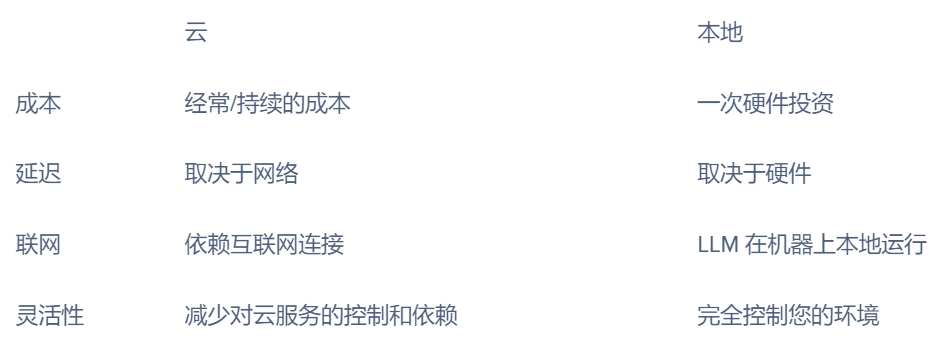

运行本地 LLM 的原因归结为成本、灵活性和安全性。

虽然基于云的模型通常需要订阅费或按使用付费,但从长远来看,在本地运行 LLM 可能更具成本效益。硬件的初始投资可能看起来很高,但通过消除持续的服务费,它得到了回报。

为了高效运行 Deepseek R1 Distill Qwen 32B 等 LLM,一个强大的系统至关重要。投资这样的硬件可以确保即使是最苛刻的型号也能运行而不会出现问题。关键要求包括:

-

GPU:我们建议使用更大内存大小的 GPU 来处理模型计算,以获得最佳性能和速度;NVIDIA 高性能 GPU(24GB)是一个不错的选择。至少 8GB 的性能仍然可以达到 GPU 的最低规格要求,但生成输出可能需要更长的时间。

-

RAM:更多的 CPU RAM 不会有什么坏处,特别是如果你的其他工作负载需要它。我们建议工作站有 32GB 或更多的 RAM,以实现流畅的多任务处理。

-

存储:由于运行 AI,特别是 LLM,数据存储速度会极大地影响性能。始终选择快速 NVMe SSD,以实现更快的数据访问和模型加载时间。

还没准备好在硬件上大举投资?混合方法允许您在本地运行 Deepseek R1 Distill Qwen 32B 等模型来执行大多数任务,并依赖基于云的服务来进行更密集的操作。这种灵活性确保您仍然可以从本地 LLM 中受益,而无需立即完全投入新硬件。

我们将介绍如何通过运行 Ollama 的容器部署我们的编码模型的步骤,Ollama 可以路由到 VS 代码接口,以便继续使用和易于访问。

1.使用 Docker 和 Ollama 设置本地环境

Docker 对于在隔离环境中运行应用程序至关重要,可确保不同设置之间的性能一致。

-

下载 Docker:访问 Docker 网站并下载与您的操作系统兼容的版本。

-

安装 Docker:按照特定于您的操作系统的安装提示进行操作。

-

验证安装:打开终端并运行 docker --version 以确保其安装正确。

Ollama 是一个允许您在本地运行和管理开源 LLM 的平台,简化了下载和配置模型的过程。

拉取、安装并运行 Ollama Docker 容器:

此命令将自动拉取最新的 Ollama 映像,在后台运行,并将其设置为在 Docker 运行时自动重启。

# Pulls latest Ollama image to run in the background

docker run -d --restart always -p 11434:11434 ollama/ollama

# Verifies Ollama is running

curl http://localhost:11434/api/version

2.下载并使用 Olama 运行 Deepseek R1 Distill Qwen 32B

Ollama 在容器中运行,我们将引导您下载、验证和测试 Deepseek R1 Distill Qwen 32B 模型。

1.识别您的 Ollama 容器:首先,使用以下命令列出所有正在运行的 Docker 容器,并找到 Ollama 集装箱的 ID 或名称。

# List all currently running Docker Containers.

docker ps

# Locate the container running Ollama & note the name and ID

2.下载 Deepseek R1 Distill-Qwen 32B 模型:使用 docker exec 命令下载 Deepseek-R1-Distill-Qwen-32B 模型。将 YOUR_CONTAINER_ID_OR_NAME 替换为您在上一步中找到的实际 ID 或名称。验证您的权限和可用的模型。

docker exec -it YOUR_CONTAINER_ID_OR_NAME ollama pull deepseek-r1:32b-qwen-distill-q4_K_M

docker exec -it YOUR_CONTAINER_ID_OR_NAME ollama list

3.测试模型:应显示下载的模型。最后,我们通过生成样本输出来测试 Deepseek R1 Distill Qwen 32B 模型。

docker exec -it YOUR_CONTAINER_ID_OR_NAME ollama run -m deepseek-r1:32b-qwen-distill-q4_K_M "Write a function to reverse a string in Python."

Continue 是一个 VS Code 扩展,它将 LLM 集成到您的编码工作流程中,提供聊天辅助和高级自动补全等功能。以下是我们如何实现 Continue 扩展:

1.安装继续扩展

-

打开 VS 代码。

-

转到扩展视图(Mac 上的 Ctrl+Shift+X 或 Cmd+Shift+X)。

-

搜索“继续”,然后单击“安装”

2.配置继续使用 Olama 和 DeepSeek-R1-Distill-Qwen-32B

-

打开扩展设置。

-

编辑 config.json 以包含模型。

// filename: config.json

{

"models": [

{

"title": "deepseek-r1-distill-qwen-32b",

"model": "deepseek-r1:32b-qwen-distill-q4_K_M",

"provider": "ollama",

"apiBase": "http://localhost:11434",

"systemMessage": "You are an expert software developer. You give helpful and concise responses. You use typescript and react with next js 14. You prefer arrow functions and more functional programmer."

},

]

}

3.验证集成:

-

打开“继续”窗口。

-

使用继续聊天功能以确保其正常工作。

如果您的本地设置缺乏运行 DeepSeek-R1-Distill-Qwen-32B 等强大 LLM 所需的硬件,您仍然可以通过使用托管模型来利用混合方法。这使您能够从高级编码辅助中受益,而无需投资专用的高端 GPU。

一些公司托管免费的 LLM,通过 API 提供访问。以下是如何获得 API 密钥与 VS 代码继续扩展集成。

GitHub 上的托管模型

GitHub 提供对各种远程托管 LLM 的访问,包括编码特定模型。如果你想在没有本地设置的情况下探索人工智能辅助编码,这是一个很好的起点。

-

导航到模型页面:访问 GitHub Marketplace,从导航菜单中选择“模型”部分。这将引导您找到可用托管模型的目录。

-

选择型号:浏览目录以查找符合您要求的型号。例如,OpenAI 的 GPT-4.0 Mini 是编码辅助的热门选择。

-

获取 API 密钥:在模型的页面上,查找“API 密钥”选项。单击它以生成密钥,您将使用该密钥将模型集成到您的工作流中。

托管在 Mistral 上的代码

Codestral 是 Mistral 托管的另一个免费模型,专为编码任务量身定制,尤其是自动完成。以下是如何访问它:

-

登录 Mistral 控制台:访问 Mistral Console 并导航到 Codestral 部分。

-

获取 API 密钥:找到 Codestral 的部分并生成 API 密钥。复制它以供以后使用。

将托管模型与 Continue 扩展集成

使用 GitHub 或 Mistral 的 API 密钥,您可以将托管模型集成到 VS Code 中的 Continue 扩展中,以实现聊天和自动完成功能。

-

打开 config.json 文件:在 VS Code 中,访问 Continue 扩展设置并找到 config.json 文件。

-

添加 API 键:将 API 键插入 config.json 中的模型数组中。以下是一个示例配置:

-

保存并重新加载:保存文件并重新加载 Continue 扩展名以应用更改。

{

"tabAutocompleteModel": {

"apiKey": "12345678901234567890",

"title": "Codestral",

"model": "codestral-latest",

"provider": "mistral"

},

"models": [

{

"title": "deepseek-r1-distill-qwen-32b",

"model": "deepseek-r1:32b-qwen-distill-q4_K_M",

"provider": "ollama",

"apiBase": "http://localhost:11434",

"systemMessage": "You are an expert software developer. You give helpful and concise responses. You use typescript and react with next js 14. You prefer arrow functions and more functional programmer."

},

{

"apiKey": "12345678901234567890",

"title": "Codestral",

"model": "codestral-latest",

"provider": "mistral"

},

{

"apiKey": "12345678901234567890",

"engine": "anything",

"apiBase": "https://models.inference.ai.azure.com"

"apiType": "azure",

"model": "gpt-4o-mini",

"title": "gpt-4o-mini",

"systemMessage": "You are an expert software developer. You give helpful and concise responses.",

"provider": "azure"

}

]

}

-

Ollama deepseek-r1-littill-qwen-32b:https://ollama.com/library/deepseek-r1:32b-qwen-distill-q4_K_M

-

Olama 文件:https://ollama.ai/docs

-

继续 VS 代码扩展:https://marketplace.visualstudio.com/items?itemName=continue.continue

通过将 Deepseek R1 Distill Qwen 32B 集成到您的本地开发环境中,您不仅采用了一种新工具,还拥抱了人工智能辅助编码的未来。凭借其卓越的性能、开源可访问性和高级功能,Deepseek R1 Distill Qwen 32B 脱颖而出,成为希望提高生产力和代码质量的开发人员的首选。

在本地运行 Deepseek R1 Distill Qwen 32B 等大型语言模型不仅仅是一种趋势,它是开发人员利用人工智能来增强其编码工作流程的一个强大转变。通过将模型引入您的机器,您可以获得基于云的服务无法比拟的速度、安全性和控制力。借助 Docker、Ollama 和 VS Code 的 Continue 扩展等工具,设置和使用本地 LLM 比以往任何时候都更容易访问。

Deepseek R1 具有各种各样的蒸馏模型,参数计数从 1.5B 开始。您现在可以在任何 GPU 上运行 Deepseek R1。为了提高速度和性能,请使用联泰集群推荐的高性能 GPU 工作站配置,联泰集群有出色的高性能 GPU 配置可选。使您的 GPU 运行计算和提取数据的能力越大、越快,输出就越快、越准确!

相关贴子

-

人工智能与大模型

人工智能与大模型几何深度学习:超越文本与图像的 AI

2025.04.18 16分钟阅读 -

人工智能与大模型

人工智能与大模型当 WA5232 G3V3 遇上 AI 研发:解锁大模型时代的终极生产力

2025.06.27 49分钟阅读 -

人工智能与大模型

人工智能与大模型为什么 Edge AI Inferencing 对人工智能的未来至关重要

2025.05.09 22分钟阅读