博客

从‘专用’到‘真共享’:高校算力资源孤岛破冰全纪实

从‘专用’到‘真共享’:高校算力资源孤岛破冰全纪实

四川某高校此项目是搭建一个赋能 HPC 及 AI 多种应用领域,覆盖流体力学、分子动力学、物理化学、仿真渲染、生命科学、气象环境检测、机器学习、大模型算法研发等多个学科的高性能智算中心。

本次项目为校内信息办监制,旨在为校内其他二级学院(生命科学、计算机科学与应用、航空航天、自动化、电子信息工程、人工智能等学院)提供高效可回收算力资源,其提供的整体资源至少包含以下几类:用于传统 HPC 且具备较高 FP64 浮点计算能力的多核高主频 CPU 计算资源、用于 AI 计算且具备较高 FP32、FP16、INT8 等浮点计算能力具备高显存的 GPU 计算资源,带宽 200Gb/s 以上的计算网络,智算中心软件管理平台,网络安全设备,基础设施建设等。上述资源进行统一整合规划,打造“安全可靠、技术先进、绿色节能、资源共享”的算力支撑平台。

针对上述项目的基本概述,汇总和各个二级学院的算力资源需求,通过整体的分析对齐,构建整体智算中心所需的系统类别主要分为:

-

基础设施建设:包含机柜基础设施、封闭冷通道系统、电池系统、配电系统、行间制冷系统、 房间制冷系统、动环监控系统。

-

算力资源池:包含管理登录节点、CPU 计算节点(FP64:360Tflops 以上)、胖节点(FP64:90Tflops 以上)、GPU 计算节点(FP16:64PFlops 以上)。

-

存储资源池:包含普通存储资源池(可用容量:1PB 以上,聚合读实测稳定带宽:60GB/s 以上)、全闪存储资源池(可用容量:10PB 以上,聚合读实测稳定带宽:160GB/s 以上)。

-

网络系统:包含带内管理网络(25GbE),带外管理网络(1GbE),存储计算网络(200GbE),防火墙。

-

软件系统:智算中心管理软件(统一管理、调度、计费)。

通过沟通发现,目前各个二级学院采用的算力资源均采用“专用”的形式,其算力资源均由各二级学院单独进行管理规划。但通过实地调研和勘探发现,看似“专用”的算力资源却存在诸多弊端,总结为以下几点:

-

资源情况:产品更新迭代速度较快,随着新老设备的更迭,由于占地和经费等多重因素,算力资源的部署扩展愈发困难。

-

资源使用:由于现阶段部署算力资源的多样,每遇到大规模算力调度计算科研任务时,算力资源的调度显得捉襟见肘,不同算力资源由于核心性能不同,或出现“木桶效应”,严重影响计算效率。

-

资源管理:大多数缺少资源统一管理的计算软件,由于各个用户涉及到的软件应用及系统驱动和依赖的不同,导致资源管理异常混乱,算力资源限制不足,运维较为困难。

-

占地供电:算力服务器占地、承重、电力等因素存在不专业、不合规的风险,出现突发情况(断电、断网)后,轻则运行的任务中断,重则造成科研数据的重大损失,得不偿失。

总结来看,看似“专用”的算力资源,实际上则是各自分散的计算资源孤岛,无法和前端的业务形成高效的对接,更无法满足科研人员的计算要求。

结合用户痛点和对需求的分析,结合用户的应用,配置对应智算中心方案,主要包含“算力资源池”、“存储资源池”、“网络系统”、“基础设施建设”、“软件系统”等模块,整体拓扑架构图如下:

关于各个模块的详细说明:

算力资源池:

-

管理登录节点:主要用于管理登录功能的节点,节点数量:4 个。

-

CPU 计算节点:共计提供 360Tflops 的 FP64 浮点计算能力,主要用于构建 CPU 算力资源池。

-

胖节点:共计提供 96Tflops 的 FP64 浮点计算能力,主要用于构建 CPU 算力资 源池。

-

GPU 计算节点:共计提供 64Pflops 的 FP16 浮点计算能力,主要用于构建 GPU 算力资源池。

存储资源池:

-

普通存储资源池:提供 10PB 可用容量,采用副本/纠删码形式,聚合读实测稳定带宽:60GB/s。

-

全闪存储资源池:提供 1PB 可用容量,采用副本/纠删码形式,聚合读实测稳定带宽:160GB/s。

网络系统:

-

带内管理网络:5 台 48 口 25GbE 以太网交换机及线缆模块。

-

带外管理网络:4 台 48 口 1GbE 以太网交换机及线缆模块。

-

存储计算网络:2 台 32 口 800GbE OSFP Infiniband 交换机,包含线缆模块,无阻塞链接。

-

防火墙:入侵防御功能,具备多种协 议和应用的攻击检测和防御

基础设施建设:

-

机柜:42U 标准机柜,尺寸:600mm×1200mm×2000mm。

-

封闭冷通道系统:形成封闭的空间,冷空气流汇入冷通道,冷空气流更有效给 IT 设备降温,无冷量损失,同时大大提高空调能效比,采用全模块式设计。

-

电池系统:采用模块化设计,单台主机可扩容容量≥600KVA,模块数可扩容数量≥12 个,本期配置 7 个 50KVA 模块,采用 6+1 备份形式。

-

配电系统:包含市电配电柜、UPS 输入配电柜、UPS 输出配电柜、精密空调配电柜,精密列头柜等。

-

行间制冷系统:总冷量:60KW,显冷量:60KW,风量:10500m3/h,加热量:6KW,加湿量:2KG/H。

-

房间制冷系统:总冷量:17.5KW,风量:4500m3/h,加湿量:3KW,加热量:3kg/h,内置变频压缩机、EC 风机,电子膨胀阀,含空调室外机。

动环监控系统:物理支撑平台,可运行动环监控系统软件,可监控 UPS、空调、精密配电柜等设备及环境检测传感器。

软件系统:

-

智算中心管理软件:配置 LtAIDC 软件,能够以裸金属、虚拟机、容器、SaaS、MaaS 等多种模 式将算力提供给用户使用,灵活、弹性地伸缩算力资源,满足用户在不同场景下的各类算力使用需求。

在部署验收完成和经过半年的试运行后,其具体用户收益如下:

-

计算能力上,远超原有计算资源的浮点计算能力,大规模提升各二级学院科研计算效率。

-

资源管理方面,使用 LtAIDC 划分不同资源池,针对不同资源池的资源整合各个租户,且分配各个资源之间相互隔离,避免了资源孤岛的情况出现,确保了算力资源的安全和使用。内置监控和计费的相关附加功能,也能实时统计各个租户/用户的资源使用情况,完成对资源高效的整合和利用。

-

算力使用层面,内置裸金属、容器、虚拟化云主机等多种资源使用方式,灵活应对各类操作系统和应用。

在联泰集群,我们致力于提供高性能计算解决方案,这些解决方案是经过验证和测试的系统。如果您对解决计算基础架构中的硬件问题有任何疑问,请与我们的技术支持团队联系,与我们联泰集群的工程师一同规划下一个算力方案决策。

相关贴子

-

技术分享

技术分享大语言模型如何突破百万 Token 上下文窗口?—— 解析上下文并行与环形注意力技术

2026.01.27 24分钟阅读 -

技术分享

技术分享技术焦点:集群管理软件

2023.01.27 41分钟阅读 -

技术分享

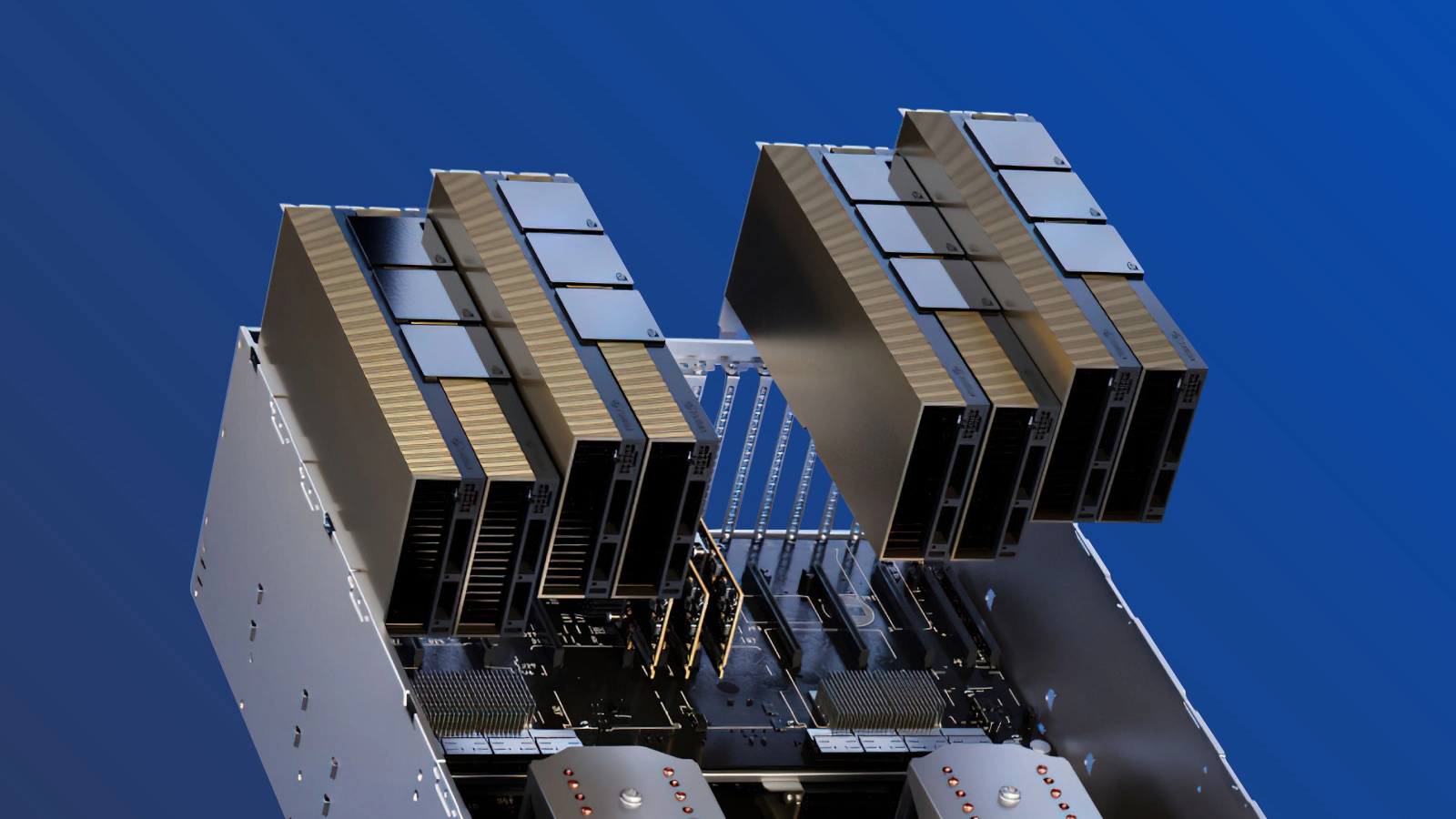

技术分享SXM 与 PCIe:最适合训练 LLM 的 GPU,如 GPT-4

2023.05.30 32分钟阅读