博客

DeepSeek 算力平台推荐方案

DeepSeek 目前的主要模型及对应的参数量如下:

●DeepSeek-V3:2024 年 12 月 26 日发布,基于混合专家(MoE)架构,参数量 671B,每次推理仅激活 370 亿参数。

●DeepSeek-R1:2025 年 1 月 20 日发布,参数量 671B,是专注于推理任务的模型。

●DeepSeek-R1 蒸馏系列模型:基于 DeepSeek-R1 蒸馏得到,参数规模从 70B 到 1.5B 不等。

备注:DeepSeek-R1 蒸馏系列模型是因为完整的满血版 DeepSeek-R1 参数量较大,需要更大的硬件资源。为了降低硬件要求,所以基于千问系列大模型和 llama 系列大模型。采用大模型蒸馏技术生成了 1.5B 到 70B 的 DeepSeek-R1 蒸馏系列模型。

模型的大小、参数数量和量化技术直接影响对显存的要求。DeepSeek 原生采用 FP8 量化技术进行部署,以下是 DeepSeek-R1 及其蒸馏模型,在 FP8 精度下的显存需求的详细分类,以及推荐的 GPU:

|

模型名称 |

参数量 |

显存需求 |

推荐方案 |

|

DeepSeek-R1-Zero |

671B |

≈1543GB |

高配方案-16 块 NVIDIA H20 或 NVIDIA H20 以上 NVIDIA 企业级 GPU 加速卡 |

|

DeepSeek-R1 |

671B |

≈1543GB |

高配方案-16 块 NVIDIA H20 或 NVIDIA H20 以上 NVIDIA 企业级 GPU 加速卡 |

|

DeepSeek-R1-Distill-Qwen-1.5B |

1.5B |

≈4GB |

入门方案-1 块 12G 或以上显存 GPU 卡 |

|

DeepSeek-R1-Distill-Qwen-7B |

7B |

≈18GB |

入门方案-1 块 24G 或以上显存 GPU 卡 |

|

DeepSeek-R1-Distill-Llama-8B |

8B |

≈21GB |

入门方案-1 块 24G 或以上显存 GPU 卡 |

|

DeepSeek-R1-Distill-Qwen-14B |

14B |

≈36GB |

进阶方案-2 块 24G 或以上显存 GPU 卡 |

|

DeepSeek-R1-Distill-Qwen-32B |

32B |

≈82GB |

进阶方案-4 块 24G 或以上显存 GPU 卡 |

|

DeepSeek-R1-Distill-Llama-70B |

70B |

≈181GB |

进阶方案-3 块 80G 或以上显存 GPU 卡 |

备注:DeepSeek-R1-Zero 和 DeepSeek-R1 需要大量的显存需求,因此推荐采用分布式 GPU 设置,并且建议多 GPU 之间采用类似 NVLINK 和 IB 的高速互联技术。

通过模型量化技术可以直接影响对显存的要求。如果 DeepSeek 采用量化技术把精度降低到 INT4 进行部署,以下是 DeepSeek-R1 及其蒸馏模型的显存需求的详细分类,以及推荐的 GPU:

|

模型名称 |

参数量 |

显存需求 |

推荐方案 |

|

DeepSeek-R1-Zero |

671B |

≈436GB |

高配方案-8 块 NVIDIA H20 或 NVIDIA H20 以上 NVIDIA 企业级 GPU 加速卡 |

|

DeepSeek-R1 |

671B |

≈436GB |

高配方案-8 块 NVIDIA H20 或 NVIDIA H20 以上 NVIDIA 企业级 GPU 加速卡 |

|

DeepSeek-R1-Distill-Qwen-1.5B |

1.5B |

≈1GB |

入门方案-1 块 8G 或以上显存 GPU 卡 |

|

DeepSeek-R1-Distill-Qwen-7B |

7B |

≈4.5GB |

入门方案-1 块 12G 或以上显存 GPU 卡 |

|

DeepSeek-R1-Distill-Llama-8B |

8B |

≈5GB |

入门方案-1 块 12G 或以上显存 GPU 卡 |

|

DeepSeek-R1-Distill-Qwen-14B |

14B |

≈9GB |

入门方案-1 块16G 或以上显存 GPU 卡 |

|

DeepSeek-R1-Distill-Qwen-32B |

32B |

≈21GB |

入门方案-1 块 24G 或以上显存 GPU 卡 |

|

DeepSeek-R1-Distill-Llama-70B |

70B |

≈46GB |

进阶方案-2 块 24G 或以上显存 GPU 卡 |

备注:DeepSeek-R1-Zero 和 DeepSeek-R1 需要大量的显存需求,因此推荐采用分布式 GPU 设置,并且建议多 GPU 之间采用类似 NVLINK 和 IB 的高速互联技术。

|

配置信息 |

信息描述 |

|

CPU |

2 块 24 核心 Intel 第三代至强可扩展处理器 |

|

内存 |

128GB 3200MHz DDR4 ECC Registerred DIMM |

|

存储 |

1 块企业级 1.92TB NVME SSD 固态硬盘 1 块企业级 16TB SATA HDD 大容量硬盘 |

|

加速卡 |

1 块 24GB 显存 NVIDIA GPU 超级加速卡 |

|

键鼠 |

USB 接口,标准键盘,USB 光电鼠标 |

|

电源 |

支持单/双电源 1600/2000/2400W |

|

网口 |

板载 2 个千兆电口 |

|

外部设备接口 |

1 个 VGA 接口,6 个 USB 3.0 接口,一套7.1 HD audio,2 个千兆电口,1 个 (USB 3.1) Type A |

|

软件系统 |

预装 Ubuntu Server 22.04 LTS 系统,其开源、稳定且对 GPU 支持良好,拥有丰富的深度学习相关软件包资源。 安装最新版 NVIDIA GPU 驱动,搭配 CUDA 12.2 工具包,充分发挥 NVIDIA 企业级 GPU 加速卡性能,为深度学习计算提供底层支持。 部署 PyTorch 2.0 及以上版本,其动态图机制和高效的计算能力非常适合 DeepSeek - R1 模型的部署与推理。 利用 TorchServe 进行模型部署,它提供了模型管理、推理服务等功能,便于快速搭建推理服务。 |

|

产品优势 |

单张 NVIDIA 超级加速卡拥有 24GB 的 GDDR6X 显存,其自带的 Tensor Core 原生支持 FP8 精度,尤其适合中小规模的 DeepSeek - R1 蒸馏系列模型,如 DeepSeek-R1-1.5B 和 DeepSeek-R1-7B。 |

| 配置信息 | 信息描述 |

|

CPU |

2 块 32 核心 Intel 第四代至强可扩展处理器 |

|

内存 |

512GB 4800MHz DDR5 ECC Registerred DIMM |

|

存储 |

2 块企业级 960GB SATA SSD 系统盘(RAID1) 1 块企业级 7.68TB NVME SSD 缓存加速盘 4 块企业级 16TB SATA HDD 大容量硬盘 (RAID5) |

|

加速卡 |

4 块液冷 24GB 显存 NVIDIA GPU 超级加速卡 |

|

键鼠 |

USB 接口,标准键盘,USB 光电鼠标 |

|

电源 |

支持单/双电源 1600/2000/2400W |

|

网口 |

板载 2 个千兆电口 |

|

外部设备接口 |

1 个 COM,6 个 USB 3.0,1 个 1Gb RJ45 管理网口,2 个 1Gb RJ45 数据网口,1 个 VGA,1 个 UID(按键及指示灯) |

|

软件系统 |

预装 Ubuntu Server 22.04 LTS 系统,其开源、稳定且对 GPU 支持良好,拥有丰富的深度学习相关软件包资源。 安装最新版 NVIDIA GPU 驱动,搭配 CUDA 12.2 工具包,充分发挥液冷 24GB 显存 NVIDIA 超级加速卡性能,为深度学习计算提供底层支持。 部署 PyTorch 2.0 及以上版本,其动态图机制和高效的计算能力非常适合 DeepSeek - R1 模型的部署与推理。 利用 TorchServe 进行模型部署,它提供了模型管理、推理服务等功能,便于快速搭建推理服务。 |

|

产品优势 |

单平台配置 4 块液冷 24GB 显存 NVIDIA GPU 超级加速卡,打造静音专属工作站! 拥有 96GB 的 GDDR6X 显存,其自带的 Tensor Core 原生支持 FP8 精度,尤其适合中大规模的 DeepSeek - R1 蒸馏系列模型,如 DeepSeek-R1-14B 和 DeepSeek-R1-32B。 |

| 序号 | 模块名称 | 规格描述 | 数量 | 单位 |

|

1 |

管理登录节点 |

用于集群管理登录/每节点 24 核心/256G 内存/1.92T SSD*2/万兆网络 |

2 |

台 |

|

2 |

分布式推理节点 |

用于提供 DeepSeek 的分布式推理能力 选用搭载 NVIDIA 企业级 NVLink H20 显存的服务器作为 GPU 节点,每台服务器配备 8 张 H20 显卡。H20 强大的计算能力与高速显存,能够为 DeepSeek 模型的推理运算提供有力支持。 |

2 |

台 |

|

3 |

专用计算网络 |

计算节点之间通过 400G IB 网络实现跨节点的数据并行。 |

1 |

套 |

|

4 |

带内管理网络 |

采用万兆交换网络。 包含满足组网的线缆、模块等 |

1 |

套 |

|

5 |

带外管理网络 |

采用千兆交换网络。 包含满足组网的线缆、模块等 |

1 |

套 |

|

6 |

集群管理软件 |

预装 LTAIDC 管理平台,融合异构计算资源池,提供给用户裸金属、容器、虚拟机等多种资源,支持租户/用户机制,支持管理、监控计费等功能; |

1 |

套 |

|

7 |

安全防护软件(可选) |

提供最先进的易用、可靠的网站、应用安全防护; 提供 SaaS、私有化部署两种方式; 提供安全专家技术支持。减少用户的数据资产风险和法律上的风险。 |

1 |

套 |

|

8 |

产品优势 |

共提供 224 个 CPU 核心,4TB 内存,61.44TB 高速缓存盘,16 块 NVIDIA H20 计算卡,可以支持满血版本 671B 大模型的加载和分布式推理部署。 节点内部采用 900GB/s 的 NVlink 互联,节点之间通过 400G IB 互联,高速响应无需等待,多卡并行任务效率飙升。 采用自研 AIDC 资源管理系统,合理分配 GPU、CPU、内存等资源,提高集群资源利用率。负载均衡策略将推理请求均匀分配到各个 GPU 节点,避免单个节点负载过高,确保集群整体的高效运行;集群性能监控模块实时监测 GPU 使用率、内存占用、网络带宽等指标,及时发现并解决潜在问题。 |

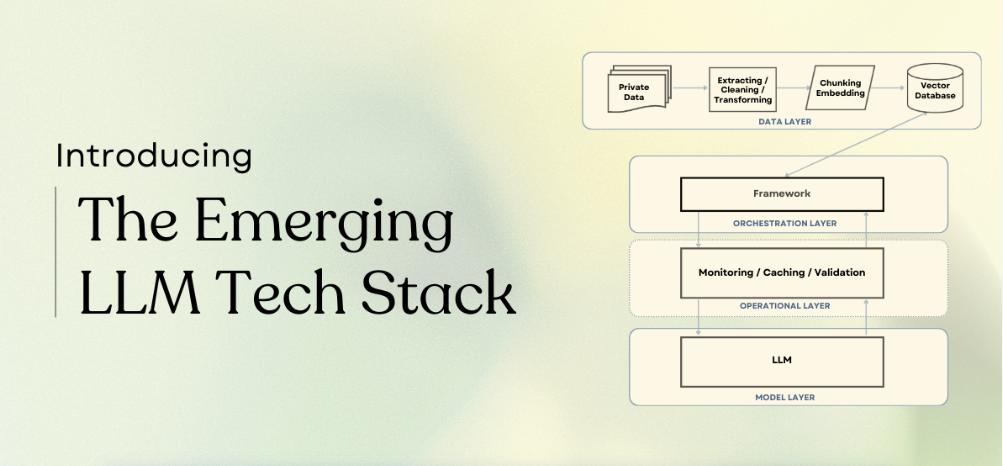

方案整体架构

(点击查看大图)

资源管理调度

联泰智算中心采用自研算力调度平台,在硬件之上,软件体系从操作系统、IaaS 管理、容器管理到模型、应用的各个层次提供了支撑,形成完整的算力管理到应用发布的大模型业务支撑体系。降低客户算力使用门槛。

集群存储系统架构

1、集群存储系统支持在线横向扩展;

2、数据存储节点可扩展到 10000 台,元数据节点扩展到 256 台,容量可达 EB 级,存储千亿文件。

应用场景-方案价值

-

面向 HPC/高性能计算、人工智能/机器学习、制造/金融、生命科学等各类算力应用场景,能够以裸金属、虚拟机、容器、SaaS、MaaS 等多种模式将算力提供给用户使用,灵活、弹性地伸缩算力资源,满足用户在不同场景下的各类算力使用需求。

-

基于算力基础设施的软硬件结构进行了系统性的优化,为用户提供优化后的高效算力,显著节省用户的算力成本支出。

-

为机器学习、大模型等 AI 研发者提供易用的开箱即用的一体化开发环境、及所需算力资源的优化调度能力,无需自行部署和运维所需的驱动、工具链以及算力调配,简单易用、快速上手、直击目标,大大提高模型研发、部署和测试效率。

-

为大模型的应用和服务提供了无需维护而又坚实可靠的应用安全防护方案,减少用户的数据资产风险和法律上的风险。

联泰集群为 AI 工程师和数据科学家提供针对用例优化的定制硬件架构,增加 GPU 算力是一项很值得的投资。如果您希望升级您的算力基础设备并提高生产力水平,请联系我们咨询您想知道的相关讯息。

相关贴子

-

人工智能与大模型

人工智能与大模型扩散和去噪——文本到图像的生成型人工智能

2024.07.19 65分钟阅读 -

人工智能与大模型

人工智能与大模型使用 Continue VS Code Extensions 在本地运行 LLM

2025.02.21 80分钟阅读 -

人工智能与大模型

人工智能与大模型深度学习指南:AI 模型中的冻结层技术

2025.09.12 60分钟阅读