博客

大型动作模型-用于执行任务的大型语言模型

大语言模型(LLMs)凭借其理解和生成广泛主题的文本的能力,彻底改变了我们的日常生产力。但是,尽管 LLM 擅长对话、总结和内容生成,但它们有一个关键的局限性:都只停留在语言上。他们可以告诉你该做什么,但他们不能为你做。

这就是语言动作模型(LAM)发挥作用的地方。LAM 建立在 LLM 的基础上,但增加了一个关键的新能力——行动。LAM 不仅可以产生响应,还可以理解意图、计划步骤,并与工具或系统交互以执行任务。无论是自动化数据库更新,还是语言驱动的机器人技术,LAM 都旨在将自然语言转化为有意义的、现实世界的结果。

语言动作模型(LAM)是一种人工智能系统,它不仅能理解语言,还能使用语言执行动作。与专注于生成文本的传统 LLM 不同,LAM 的构建是为了解释命令、计划下一步行动和采取行动。大型动作模型(LAM)旨在理解人类的意图,并将其转化为给定环境或系统中的动作。

LAM 将语言理解与工具使用、决策和记忆相结合。它们可以调用 API,与应用程序交互,并参考过去的上下文来完成复杂的任务,同时与用户自然地进行通信。

关键用例

LAM 在任何自然语言可以驱动实际行动的地方都很有用。常见应用包括:

-

工作流自动化:通过聊天界面触发生成报告、更新数据库或管理电子邮件等序列。

-

个人助理和机器人:安排会议、设置提醒或通过解释自然命令来控制智能设备。

-

开发人员工具:在集成开发环境(IDE)中编写、编辑、运行代码和/或基于文本的指令。

-

研究代理:从大量文档或数据中搜索、阅读、总结和汇编见解。它还可以根据文档填写标签数据。

这些用例展示了 LAM 如何弥合沟通和执行之间的差距,使 AI 更加实用和动手。

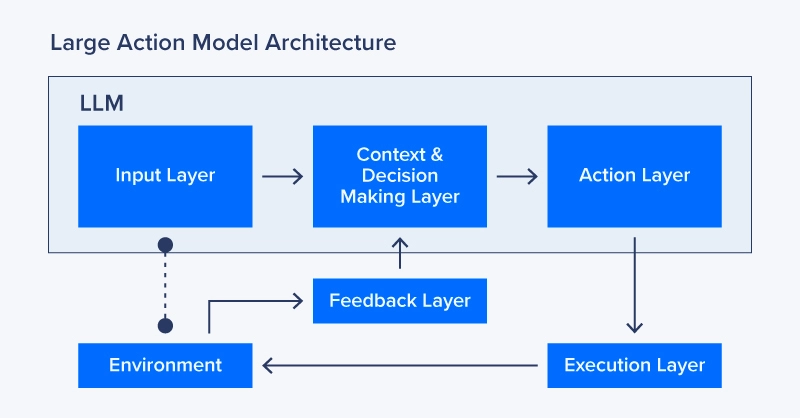

LAM 通过一系列相互连接的组件运行,使它们能够理解语言、做出决策和执行任务:

-

输入层:由基础 LLM 提供支持,输入层接收文本或语音输入,以理解用户请求的上下文。

-

上下文和决策层:解释目标,将上下文加载到内存中,并评估情况和环境,以确定完成任务的最佳方法。

-

行动层:基于上下文和决策层,行动层将通过将我们的上下文映射到具体的行动计划来选择行动。这可以包括 API 调用、系统命令、文本输出响应或其他映射函数。

-

执行层:执行由操作层制定的行动计划,如调用 API、使用工具、查询数据库等。

-

反馈层:将整个过程的结果反馈给模型,以评估成功或失败。该层可以触发重试、调整和学习更新。

这是一个个人机器人的语言动作模型的例子。在这种情况下,计算机视觉是必要的。NVIDIA 已经开发了与人形机器人对话和互动的功能。如果你让你的机器人把一个苹果放在篮子里,我们可以使用一个大型动作模型。

1.输入层:向模型提供语音或文本提示,以理解用户的指令:例如,“你能从厨房给我拿杯苏打水吗?”输入层使用 LLM 解析命令,识别所涉及的对象(“苏打水”、“厨房”),并将其转化为结构化目标。

2.上下文+决策层:确定高级计划。首先,它将决定意图:“导航到厨房,找到一杯苏打水,抓住它,回到用户身边”,还可以查询记忆厨房在哪里?苏打水是什么样子的?

3.行动层:将计划转化为具体的行动步骤。

-

生成特定命令,例如:

-

导航到(location="kitchen")

-

检测对象(label="soda can")

-

抓取对象(object_id=42)

-

导航到(location="user")

-

释放对象(object_id=42)

4.执行层:使用低级机器人控制和传感器执行每个命令。

-

控制电机移动到厨房。

-

通过摄像头进行物体检测。

-

命令手臂抓住并移动。

-

监控传感器以避免碰撞、物体抓握反馈等。

5.反馈层:评估每个步骤是否成功。如果未检测到“苏打水”:请重试检测或升级错误。如果“抓握”失败:调整位置并重试。如果“用户”移动:重新计算路线。

虽然语言动作模型(LAM)解锁了高级功能,但它们的部署需要精心设计,以确保可靠性、安全性和性能。以下是需要考虑的关键因素:

关键部署因素

-

工具和 API 集成:LAM 必须与外部系统接口以执行任务。这需要强大的 API 连接器、清晰的输入/输出模式和安全的身份验证协议。

-

系统复杂性:LAM 管道可能包括意图解析、规划模块、工具执行、内存管理和监控。编排这些组件需要模块化设计和明确的系统边界。

-

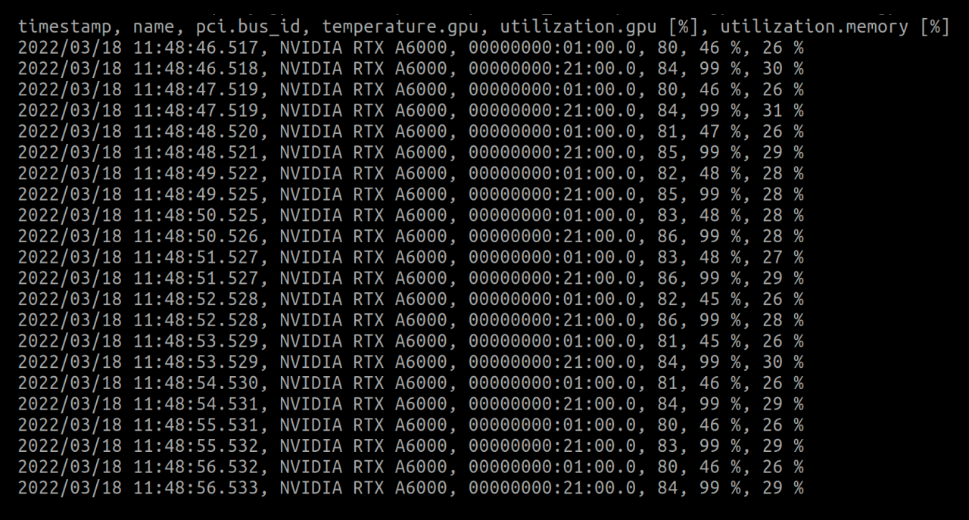

计算要求:根据模型大小和任务复杂性,实时 LAM 推理可能需要 GPU 加速,特别是在涉及推理或多步规划的情况下。

-

记忆和上下文:持久的用户和任务上下文可以提高性能和个性化。安全地存储和检索相关会话或用户历史对于连续性至关重要。

-

安全和治理:LAM 可以采取现实世界的行动,因此定义严格的执行权限、跟踪决策和内置覆盖机制以防止误用或失败非常重要。

-

性能和延迟:每个 LAM 循环——意图识别、计划、执行——都会增加延迟。低延迟规划、缓存和预处理可以提高响应速度。

LAM 部署的最佳实践

要构建一个强大且可扩展的 LAM 驱动系统,请考虑以下最佳实践:

-

从受控范围开始:限制 LAM 早期可以访问的工具或 API 的数量。专注于稳定、记录良好的端点,并逐步扩展。

-

模块化架构:将模型推理、规划逻辑、工具执行和内存处理分离为清晰的组件。这有助于调试、扩展和维护。

-

实现基于角色的访问控制(RBAC):使用 RBAC 和作用域根据任务或用户角色限制LAM的功能。这可以防止意外或未经授权的行为。

-

回退和确认机制:对于影响较大的操作,在执行之前实施用户确认步骤或验证提示。

-

监控和记录操作:维护所采取操作、决策跟踪和用户输入的详细日志,以支持可观察性、审计和事件响应。

-

尽可能使用轻量级规划:当规则或启发式方法足够时,避免复杂的推理。简化规划可以显著降低延迟和错误风险。

-

环中人设计(HITL):在早期部署中,让人监督 LAM 生成的关键决策或计划,特别是在敏感应用中。

语言动作模型(LAM)通过将自然语言转换为可执行动作,建立在传统语言模型的基础上。LAM 具有意图识别、规划和工具使用等功能,使系统能够自主完成任务。

这一转变解决了 LLM 的核心局限性——它们无法采取行动——并为更智能、更高效的自动化打开了大门。随着人工智能应用的增长,LAM 将成为开发能够独立高效运行的代理的基础。

LAM 代表了构建系统所需的基础设施,这些系统不仅能理解指令,还能以有意义的、目标导向的行动做出响应。

相关贴子

-

人工智能与大模型

人工智能与大模型SR223 V2 服务器 - 推动企业技术革新的关键力量

2024.09.06 33分钟阅读 -

人工智能与大模型

人工智能与大模型深度学习、生命科学和内容创作中的生成型人工智能用例

2024.01.26 40分钟阅读 -

人工智能与大模型

人工智能与大模型科研效率翻倍!联泰集群国产液冷一体机 WK7234,解锁计算新体验

2025.11.28 58分钟阅读