博客

当 WA5232 G3V3 遇上 AI 研发:解锁大模型时代的终极生产力

单机最高 256 核 512 线程,搭载双路 AMD EPYC 9005/9004 处理器,单机最高可拥有 256 核 512 线程 。如此庞大的核心数量和线程数,意味着它具备极其强大的并行处理能力。无论是复杂的数据分析、大规模的科学计算,还是高强度的AI训练任务,都能轻松应对。

高速内存,百亿参数模型全内存计算不是梦

配备 24 通道 DDR5 - 5600 内存,总容量可达 6TB,这一内存配置堪称豪华。高频率的 DDR5 内存带来了更快的数据传输速度,而 24 通道的设计则进一步提升了内存带宽,使得数据的读写更加高效。

灵活存储,满足多元需求

搭配四块 SATA/SAS/U.2 热插拔混搭硬盘,这种灵活的硬盘组合方式,可以满足不同用户对于存储容量和读写速度的需求。如果用户需要大容量的存储来保存大量的数据,SATA 硬盘可以提供较高的存储容量;而对于那些对读写速度要求极高的应用场景,如数据库系统、高速数据缓存等,SAS 或 U.2 硬盘则可以提供更快的数据传输速度。热插拔功能更是方便了用户在不关闭服务器的情况下更换硬盘,大大提高了系统的可用性和维护效率。

GPU 扩展:双路并行的视觉与 AI 加速引擎

支持最大两张 GPU 并行运算,在 AI 训练场景中,双 GPU 架构可将模型训练速度提升数倍,显著缩短生成式AI从研发到商用的周期;而在影视特效制作领域,双 GPU 并行渲染能大幅压缩成片时间,通过 AMD 优化的异构计算框架,EPYC 处理器与 GPU 之间的数据交互延迟降至最低。在医疗影像分析场景中,CPU 负责快速处理海量影像数据,GPU 则专注于病灶识别的深度学习计算,二者协同作业,既保证数据处理效率,又能实现高精度诊断,为医疗智能化升级提供强力支持。

行业场景化解决方案

|

行业领域 |

核心价值点 |

技术支撑 |

|

AI 研发企业 |

千亿参数 MoE 模型推理延迟≤5ms,支持 FP8 混合精度训练 |

双 EPYC 9755+双 NVLink GPU,液冷系统保障 350W 持续算力输出 |

|

汽车自动驾驶 |

多模态感知融合处理时延 ≤2ms,支持 300km/h 极端场景仿真 |

PCI-e 5.0×24 通道实现传感器数据零拷贝,NVMe 存储达 200 万 IOPS |

|

高校科研 |

分子动力学模拟效率提升 6 倍,支持百万原子级实时可视化 |

24 条 DDR5-6400 内存全通道填充,带宽达 845GB/s |

|

影视特效 |

8K 实时渲染支持 18bit 色深,UE5 渲染速度提升 70% |

双 GPU 通过 NVLink 互联显存池,配合 512MB L3 缓存加速光线追踪 |

|

医疗影像 |

全切片病理分析速度提升 8 倍,支持 4D 器官建模 |

ECC 内存纠错 +3D XPoint 持久内存保障数据完整性 |

|

金融科技 |

高频交易响应<50μs,风险模型迭代周期缩短至 2 小时 |

DDR5-6400 内存延迟压至 65ns,QP 加速器提升加密运算效率 |

|

通信运营商 |

5G 核心网用户面处理能力达 400Gbps,NFV 实例密度提升 3 倍 |

128 条 PCI-e 5.0 通道支持 DPU 卸载,网络包处理延迟<5μs |

|

航空航天 |

计算流体力学仿真精度达 0.01mm,风洞实验替代率提升 40% |

AVX-512 指令集加速 CFD 运算,双精度浮点性能 4.8TFLOPS |

|

大数据分析 |

实时流处理吞吐量达 20TB/小时,Spark SQL 查询速度提升 5 倍 |

192 核 384 线程并发处理,NVMe over Fabric 加速分布式存储 |

相关贴子

-

人工智能与大模型

人工智能与大模型芯片制造商推动 AI 的标准化 FP8 格式

2022.07.14 0分钟阅读 -

人工智能与大模型

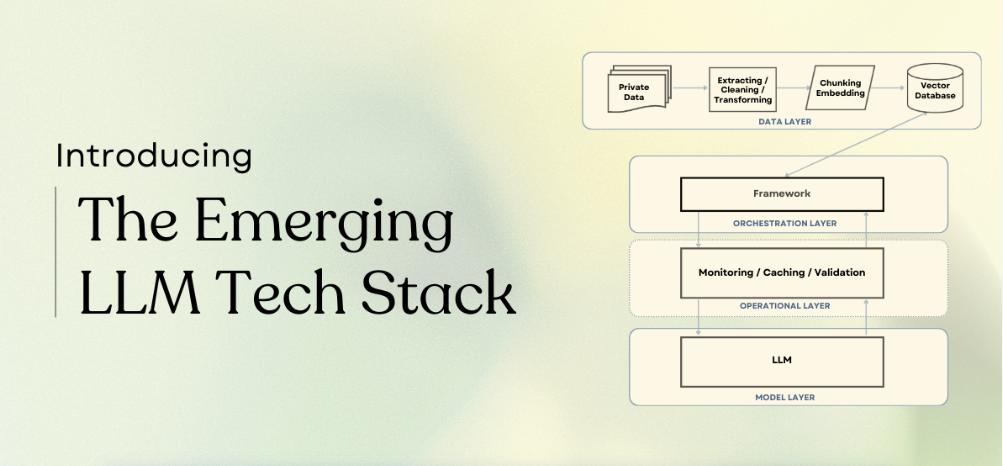

人工智能与大模型新兴的 LLM 技术堆栈

2024.03.14 152分钟阅读 -

人工智能与大模型

人工智能与大模型异构集群助力全球车厂智驾升级

2025.04.25 22分钟阅读