博客

每秒 300MB→15GB!看这家企业如何打破存储‘龟速’魔咒?

某大型高科技企业集团专注于高性能计算与数据密集型业务,涉及信号处理、智能分析等科研领域。随着业务规模扩大,数据量快速增长,现有存储系统在性能、扩展性和数据安全方面面临挑战,亟需构建新一代存储平台,以支撑前端计算业务的高效运行。

-

高性能存储支撑:现有存储系统(NFS 文件系统)的读写效率较低(实测仅 300MB/s),无法满足 AI 训练、科学计算等业务的高吞吐需求。

-

弹性扩展能力:需新增 400TB 存储容量,并支持未来灵活扩容,避免资源孤岛问题。

-

数据高可用与安全:需支持纠删码/多副本机制,确保数据可靠性,同时兼容现有计算集群。

-

性能瓶颈:传统磁盘阵列扩展方式导致 I/O 效率下降,影响计算任务执行效率。

-

管理复杂:存储资源分散,难以统一调度,形成数据孤岛。

-

安全风险:缺乏高效的数据冗余机制,存在单点故障隐患。

采用分布式存储架构,构建高性能、高可扩展的统一存储资源池,关键设计如下:

✅ 高性能存储集群:优化数据分布策略,提升大文件读写效率(目标≥15GB/s)。

✅ 弹性扩展架构:支持在线扩容,避免性能随容量增长而下降。

✅ 数据高可用:支持多副本与纠删码,保障数据安全性与业务连续性。

✅ 无缝对接计算平台:与现有 GPU 计算集群深度集成,优化数据访问效率。

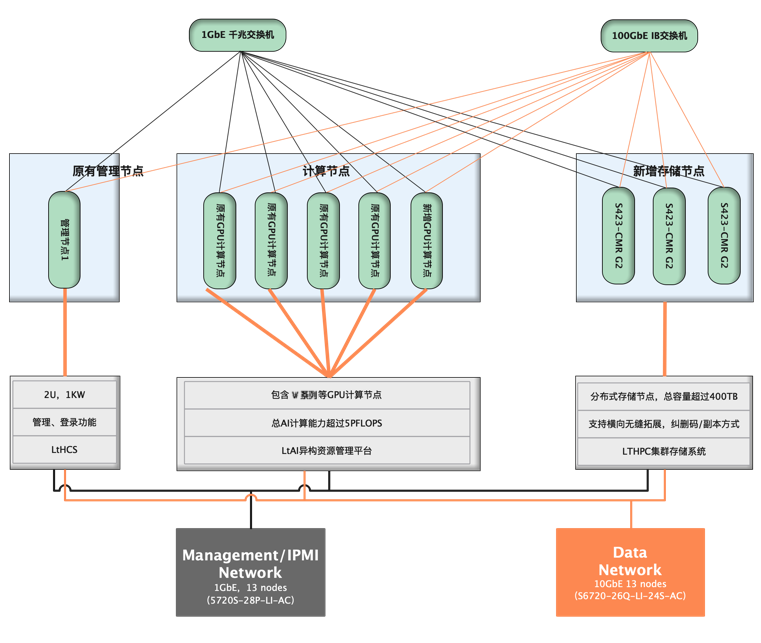

管理节点:用户原有双路 Intel Xeon CPU 管理服务器。

计算节点:新购部分双路 Intel 8 GPU 卡服务器,用户原有 V系列 GPU 服务器 3 台;

分布式存储节点:联泰集群 S1000 24 盘位分布式存储一套;

网络部分:千兆交换机1台, 100GbE IB 交换机 1 台;

集群管理:LtAI 异构资源管理平台,搭建统一AI计算资源池;

分布式存储平台:LTHPC 集群存储系统,搭建高性能存储资源池;

-支持副本/纠删码技术特性;

-支持在线横向扩展,容量可达 EB 级;

-支持 NFS/SMB/POSIX 等协议,无性能瓶颈;

-多级可靠性保障,保证业务连续性和安全性;

-支持非结构化数据之间协议融合互通访问,基于 ROW 的可以快照功能等。

分布式存储系统在部署和半年的试运行后,用户对本次方案的使用情况和具体服务高度赞赏,其具体用户收益如下:

-分布式存储的数据读写效率远远优于原有磁盘阵列,整体文件读写效率由 300MB/s 左右提升到 15GB/s,在一定程度上推动了业务的发展;

-分布式存储支持 RDMA、GDS 等技术,对前端 GPU 服务器的增速巨大,超额完成训练任务;

-纠删码/副本的部署方式,一定程度上保证了用户的数据安全;

-无缝拓展分布式存储节点,解决用户存储资源孤岛问题等。

相关贴子

-

存储

存储联泰集群成功通过分布式存储测试,打造安全可靠的存储解决方案

2023.08.29 5分钟阅读 -

存储

存储为人工智能训练和推理扩展存储的技巧

2023.02.17 72分钟阅读 -

存储

存储企业数据存储集群解决方案——本地、云与混合存储

2025.02.08 33分钟阅读