博客

GROMACS 2025.3 补丁版本发布说明

GROMACS 2025.3 于 2025 年 8 月发布。该第 3 版补丁修复了 2025 系列先前版本发布后发现的若干问题。GROMACS 建议 2025 系列的所有用户升级至 2025.3 版本。

以下是部分核心更新亮点,详细内容可通过复制下方链接到浏览器查看!https://manual.gromacs.org/2025.3/index.html

1. 自由能 lambda 坐标的 AWH 功能未激活

当 AWH(适应性偏置力)用于自由能 lambda 坐标(且无其他维度)时,lambda 状态会保持在初始状态,导致所有计算得出的自由能均为零。受影响版本:2024.4、2024.5、2025.0、2025.1 及 2025.2。

2. 无独立 PME 进程时,AWH 偏置共享导致错误

当多个模拟之间启用 AWH 偏置共享,且每个模拟使用多个进程但未配置独立 PME(粒子网格 Ewald)进程时,mdrun 会出现段错误(segfault)。该问题不会导致计算结果异常。受影响版本:2024.5、2025.0、2025.1 及 2025.2。

3. gmx mdrun 新增输入与模块化模拟器不兼容时的报错机制

默认情况下,gmx mdrun 会优先选择模块化模拟器(若适用),必要时回退至传统模拟器。用户可通过官方文档中记载的环境变量指定运行模式。此次修复后,GMX_USE_MODULAR_SIMULATOR 环境变量的配置将被正确识别;若模拟任务无法使用模块化模拟器,系统会直接抛出错误提示。

1. SYCL 构建在 BUILD_SHARED_LIBS=off 时可正常运行

此前,当设置 BUILD_SHARED_LIBS=off(静态库构建模式)时,gmx 可执行文件及部分测试二进制文件因缺少链接 SYCL 运行时库所需的信息,无法与 libgromacs.a 成功链接。此次修复后,SYCL 构建模式下的可执行文件链接流程更具稳定性。

2. 支持 ROCm 7 及更高版本的构建

由于主要 HIP 库的链接行为发生变更,此前 GROMACS 在 ROCm 7 及以上版本中无法正常构建和链接;同时,ROCm 7 中移除了 __AMDGCN_WAVEFRONT_SIZE 宏定义,导致构建失败。此次更新已兼容上述变更。

3. 优化 SYCL + VkFFT 配置的错误提示(针对 Intel 设备)

当针对 Intel 设备配置 SYCL + VkFFT 时,此前的错误提示会误导用户认为 SYCL 完全不支持 VkFFT。此次修复后,错误提示已明确说明:该不支持仅针对 Intel 设备。

4. 修复配置阶段 MKL GPU 卸载库的检测逻辑

此前,若未找到 MKL GPU 卸载库的开发头文件,配置流程仍会正常继续,导致后续编译失败。此次修复后,该场景下会直接抛出配置错误,便于用户及时排查问题。

5. 修复 NVIDIA sm_101 /sm_110 设备的构建问题

已解决针对 NVIDIA sm_101 /sm_110 架构 GPU 的编译构建失败问题。

1. 补充多副本模拟中 PME 调优的文档说明

PME 调优会在物理模型等效的前提下选择不同计算方案,但多副本模拟中不同副本的调优结果可能不一致,导致势能对比的细节出现意外差异。建议在特定场景(如使用 PLUMED 进行哈密顿量副本交换模拟测试)中禁用 PME 调优。

2. 修正 GPU 模式下域分解次数的日志统计

使用 GPU 时,日志文件末尾的周期计数表中 “Domain decomp.(域分解)” 的调用次数统计存在偏差,实际数值为正确值的(1 + 分解维度数)倍。此次修复仅修正统计显示,实际计算时间和周期计数不受影响。

3. 新增 NVIDIA CUDA 13 工具包的编译支持

添加必要的编译选项,解决使用 CUDA 13 工具包中的 NVCC 编译器时出现的构建失败问题。

4. 避免安装第三方头文件

修复了 GROMACS 安装时会附带 muParser 头文件的回归问题,该问题曾导致与独立安装的 muParser 包发生冲突。

5. libgromacs 仅在明确需要时链接 MPI 库

此前,gmxapi 可能会误触发 GROMACS 编译并链接 MPI 库,此次更新已修复该问题。

6. 调整 gmxapi 选项与 MPI 包的查找顺序

此前,gmxapi 配置在 MPI 库查找之后执行,导致后续 CMake 运行时会自动查找 MPI 库以支持 gmxapi,即使 libgromacs 并不需要。此次调整后,CMake 缓存在多次运行中不会出现此类波动。

7. 优化 AMD gfx94x 架构的 NBNXM 内核选择策略

对于 AMD gfx94x 设备,默认采用解析型 Ewald 内核(Analytical Ewald kernels),该内核在大多数常见场景下性能更优;例外情况:当使用 SYCL 后端且启用 vdw-modifier=Force-switch(范德华力修正为力切换模式)时,仍使用查表型内核(tabulated kernels)。

相关贴子

-

人工智能与大模型

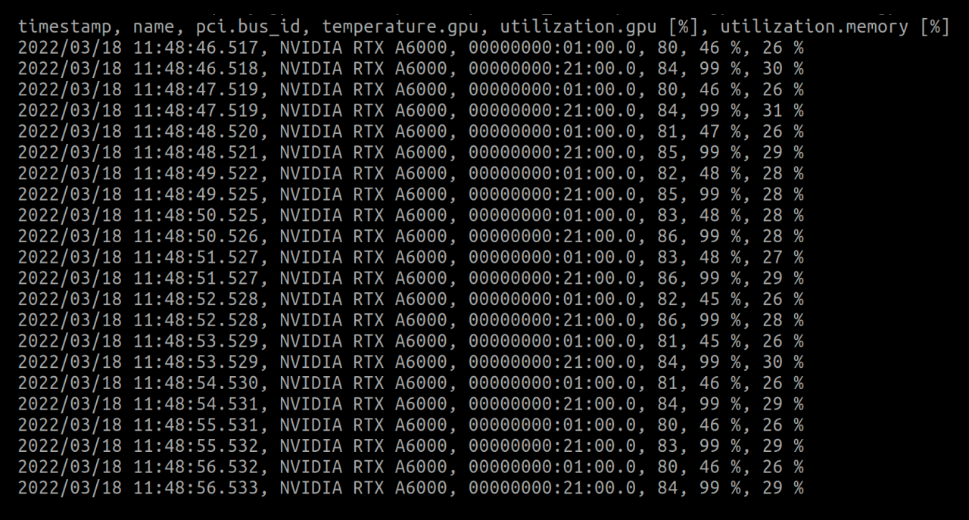

人工智能与大模型监测和改善深度学习的GPU使用情况

2022.07.14 0分钟阅读 -

人工智能与大模型

人工智能与大模型LLMs 的历史与未来

2024.09.20 46分钟阅读 -

人工智能与大模型

人工智能与大模型最大限度地提高人工智能效率——超参数调整和调节

2025.01.17 25分钟阅读